加我微信:laozhangdaichong7。确保你能用上 ChatGPT 官方产品和解决 Plus 升级的难题。本站相关服务↓

- ChatGPT一直转圈,专用网络美国海外专线光纤:老张渠道八折优惠。立即试用>

- GPT3.5普通账号:美国 IP,手工注册,独享,新手入门必备,立即购买>

- GPT-4 Plus 代充升级:正规充值,包售后联系微信:laozhangdaichong7。下单后交付>

- OpenAI API Key 独享需求:小额度 GPT-4 API 有售,3.5 不限速。立即购买>

- OpenAI API Key 免费试用:搜索微信公众号:紫霞街老张,输入关键词『试用KEY』

下单后立即获得账号,自助下单 24小时发货。很稳定,哪怕被封免费换新,无忧售后。

立即购买 ChatGPT 成品号/OpenAI API Key>>

请点击,自助下单,即时自动发卡↑↑↑

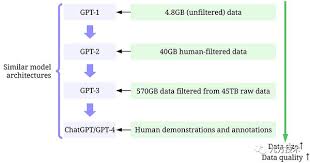

ChatGPT的训练方法与GPT-3的对比

ChatGPT和GPT-3是由OpenAI公司开发的语言模型。它们都是通过训练大量文本数据来产生响应的自然语言生成模型。然而,ChatGPT和GPT-3在训练方法上存在一些差异。

ChatGPT的训练方法

ChatGPT的训练可以分成三个步骤:

- 无监督预训练

- 监督微调

- 指令微调

首先,ChatGPT进行无监督预训练。在这一步骤中,模型从大量无标签的文本数据中学习语言的基本结构和语义。通过这个过程,ChatGPT可以掌握多种不同类型的单词、短语和语法结构。

接着,ChatGPT进行监督微调。在这个阶段,开发者使用人工标注的数据集来优化已有的模型。通过对人类指令的学习和优化,ChatGPT可以更好地理解并生成与人类交流的自然语言响应。

最后,ChatGPT进行指令微调。这一步骤使用强化学习的奖励模型来优化模型的策略。开发者根据提示和强化学习方法对模型进行优化,使其能够对不同情境下的对话作出更好的回应。

GPT-3的训练方法

相比之下,GPT-3的训练方法主要侧重于构建一个庞大的自回归语言模型:

- 1750亿参数的自回归语言模型

- NLP数据集评估

OpenAI训练了一个拥有1750亿参数的自回归语言模型,也就是GPT-3。该模型使用大量的文本数据进行训练,旨在提高模型对上下文的理解和生成能力。

GPT-3在自然语言处理(NLP)数据集上进行了评估,以测试其在各种任务上的性能和快速适应能力。

综上所述,ChatGPT和GPT-3在训练方法上存在差异。ChatGPT通过无监督预训练、监督微调和指令微调三个步骤来训练模型,使其能够更好地理解和生成自然语言响应。而GPT-3主要是通过构建一个庞大的自回归语言模型来提高模型的上下文理解能力。

(参考链接:”ChatGPT的训练方法及步骤详解(chatgpt训练)“)

ChatGPT与GPT-3的训练方法对比解析

ChatGPT和GPT-3都是由OpenAI开发的语言模型,它们是在来自各种来源的大量文本数据上进行训练的。这两种模型都能够对文本输入产生类似人类的响应,而且都采用了预训练和微调的方法进行训练。然而,ChatGPT和GPT-3在训练方法上存在一些区别和优劣势。

ChatGPT的训练方法

- 无监督预训练

- 监督微调

- 指令微调

ChatGPT的训练过程第一阶段是无监督预训练。通过学习大量无标签文本数据,使模型能够掌握语言的基本结构和语义。这样的预训练方法可以帮助模型学习到丰富的语言知识,但在训练过程中,模型无法获得与特定任务相关的指导性信息。

第二阶段是监督微调,即对已有的训练模型进行微调。通过人工标注的数据集优化模型,使其能够理解不同类型的人类指令。监督微调可以提高模型在特定任务上的表现,但需要耗费大量的人力和时间进行数据标注和模型优化。

第三阶段是指令微调,采用强化学习的方法对模型进行优化。开发者使用提示和强化学习方法来训练模型,使其对更好的对话响应做出更高的奖励。指令微调可以进一步提升模型的性能,但需要较高的技术和专业知识。

GPT-3的训练方法

GPT-3采用了一种不同的训练方法,它训练了一个包含1750亿参数的自回归语言模型。在训练过程中,GPT-3使用了大量的无监督数据和任务特定数据。通过对大量文本进行预训练,GPT-3能够掌握丰富的语言知识和语义,使其在各种不同的任务上都能表现出色。

GPT-3的训练方法与ChatGPT相比具有以下优势:

- 训练规模更大:GPT-3训练了一个包含1750亿参数的模型,比ChatGPT的规模更大。这使得GPT-3具有更强大的学习能力和语言理解能力。

- 更广泛的训练数据:GPT-3使用了大量的无监督数据和任务特定数据进行训练,使模型在各种任务上都能表现出色。

- 更全面的语言理解:由于训练规模更大、数据更丰富,GPT-3能够更全面地理解语言的结构和含义,使得其响应更加准确和贴切。

总结

ChatGPT和GPT-3都是通过预训练和微调的方法进行训练的语言模型。ChatGPT通过无监督预训练、监督微调和指令微调三个阶段的训练,使模型逐步优化。GPT-3则采用了1750亿参数的自回归语言模型,通过大规模训练数据和任务特定数据进行训练,具有更强大的学习能力和语言理解能力。

ChatGPT训练方法详解

ChatGPT的训练方法可以分为三个阶段:无监督预训练、监督微调和指令微调。

无监督预训练

ChatGPT的训练流程首先进行无监督预训练,目的是让模型能够学习语言的基本结构和语义,为后续的微调过程奠定基础。在预训练阶段,模型使用大量的文本数据作为输入,通过自我生成任务,学习如何预测下一个词。通过多轮的迭代训练,模型逐渐提高了对语言的理解能力。

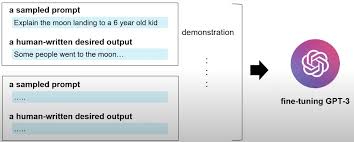

监督微调

在无监督预训练之后,进入了监督微调的阶段。在这个阶段,模型使用人工标注的数据集进行训练,通过与标注的示例对话进行对比学习,使模型能够更好地理解人类指令并生成合理的回复。为了提高训练效果,数据集可以包括各种类型的对话,涵盖不同领域和用途场景。

指令微调

最后一阶段是指令微调,通过对模型进行强化学习的优化,使其能够对更好的对话响应做出更高的奖励。在这个阶段,开发者使用提示和强化学习方法来优化模型的策略。通过不断与模型互动,并根据与模型的对话结果给予奖励或惩罚,逐步优化模型的生成能力和响应质量。

总的来说,ChatGPT的训练方法综合运用了无监督预训练、监督微调和指令微调三个阶段,使模型在语言理解和生成能力上得到全面的提升。这种训练方法不仅可以应用到ChatGPT这样的对话生成模型中,也可以推广到其他自然语言处理任务中,为各种应用场景提供更准确、流畅的文本生成能力。

参考链接:ChatGPT如何进行训练

GPT-3训练方法概述

GPT-3是一个参数达到1750亿的自回归语言模型。OpenAI使用NLP数据集对GPT-3进行了训练和评估,在实验中测量了其上下文学习能力和快速适应训练的效果。

从图4中我们可以看出,InstructGPT/ChatGPT的训练可以分成3步,其中第2步和第3步是的奖励模型和强化学习的SFT模型可以反复迭代优化。 根据采集的SFT数据集对GPT-3进行了训练。

训练和评估

GPT-3是目前参数最多的自回归语言模型,采用了1750亿个参数进行训练。OpenAI使用大规模的自然语言处理(NLP)数据集对GPT-3进行了预训练和微调。在预训练阶段,GPT-3通过大量的文本数据学习语言模式和上下文理解能力。随后,在特定任务上进行微调,对模型进行优化和适应。

为了评估GPT-3的性能,OpenAI进行了一系列实验。通过对不同类型的任务进行测试,评估GPT-3在多个领域的应用能力。实验结果表明,GPT-3在自然语言处理任务中表现出色,具有优秀的生成和回答能力。

快速适应训练

GPT-3具有强大的快速适应训练能力。它可以通过一定数量的样本来学习新的任务或领域知识,而无需大规模的重新训练。这种快速适应训练的能力使得GPT-3成为一个灵活且高效的语言模型。

为了实现快速适应训练,OpenAI采用了奖励模型和强化学习的SFT(Structured Feedback Transfer)模型。通过对SFT数据集进行迭代优化,GPT-3能够快速学习新的任务或领域,并生成符合要求的文本。

应用情况

- GPT-3的训练方法和技术架构为自然语言处理领域带来了巨大的影响和意义。

- GPT-3在语言生成、文本补充、文本推断等任务中展现出了强大的能力。

- 通过快速适应训练的方式,GPT-3可以广泛应用于各种自然语言处理任务,包括对话系统、问答系统、机器翻译等。

参考链接:OpenAI API功能介绍与接入流程