ChatGPT网络结构详解(chatgpt的网络结构)

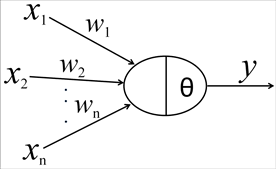

ChatGPT网络结构详解(ChatGPT的网络结构)。ChatGPT是基于Transformer神经网络架构的自然语言处理工具,采用了GPT-3的网络结构。它主要由两个部分组成:变换器编码器和自回归解码器。变换器编码器对输入文本进行编码,转换为中间表示形式。自回归解码器利用之前生成的标记来预测下一个标记,生成连贯的回复。ChatGPT使用指示学习构建训练样本,并通过奖励模型的打分指导强化学习。它可应用于聊天机器人、虚拟助手、智能客服等场景,实现个性化的对话交互体验。详细内容请参考https://mingshantou.com/chatgpt-network-structure-4。