ChatGPT训练数据指南-如何使用和构建训练数据(chatgpt训练数据)

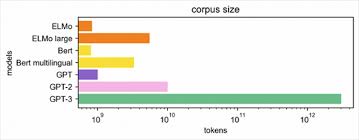

ChatGPT是一种语言生成模型,用于产生具有上下文和语义的人机对话。它的训练数据主要来自于互联网上的文本数据,包括维基百科、新闻、社交媒体等。这些数据集非常庞大,通常需要通过爬虫和其他方式进行收集和整理。

维基百科是一个由志愿者创建和编辑的免费在线百科全书,它覆盖了广泛的主题和领域,提供了丰富的知识和信息。ChatGPT使用维基百科作为训练数据之一,从中获取知识和信息,以提供丰富的回答和对话。

新闻和社交媒体是即时的信息源,可以提供最新的事件和话题。ChatGPT从这些来源中获取训练数据,使得它能够对当前的新闻、事件和流行话题做出回应。这种实时性和多样性使得ChatGPT能够更好地理解并回答用户的问题。

书籍是另一个重要的训练数据来源,ChatGPT使用了大量的书籍文本作为训练数据,这些书籍涵盖了各种主题和领域。通过使用书籍数据,ChatGPT能够从不同的作者和视角获取信息,并提供不同的观点和回答。

网页是互联网上最常见的文本形式之一,ChatGPT通过爬取网页并提取其中的文本数据来获取训练数据。这些数据包括了网页上的文章、博客、论坛帖子等。由于网页内容的广泛性和多样性,ChatGPT能够从中获得各种信息,并应对不同的用户查询。

另外,Common Crawl数据集是一个公开可用的网页语料库,包含了大量的网页文本数据。这个数据集覆盖了来自不同语言、不同领域的文本,包括新闻、博客、论坛等。ChatGPT可以通过使用Common Crawl数据集来增加训练数据的多样性,从而提高模型的性能和泛化能力。

构建ChatGPT的训练数据是创建一个高质量、多样性和可控性的对话模型的关键步骤。数据收集是构建训练数据的第一步,常用的方法包括使用爬虫技术从互联网上抓取数据,利用维基百科等在线百科全书的数据,以及使用Common Crawl数据集等。收集到的数据需要经过预处理和训练过程,最终构建出ChatGPT的训练数据。

通过以上的数据来源和构建过程,ChatGPT能够获取丰富的语言知识,并能够对各种主题和领域做出回应。这使得ChatGPT成为一个有用的人机对话生成模型,可以广泛应用于自然语言处理和人工智能领域。