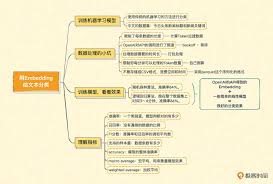

OpenAI Embedding: 详解OpenAI向量模型及其在API中的应用和示例

在现代人工智能领域,Embedding(嵌入)作为一种将文本、单词或短语转换成数值向量的技术,被广泛应用于自然语言处理(NLP)任务中。今天,我们将深入了解OpenAI提供的Embedding向量模型及其在API中的应用和具体示例。OpenAI Embedding是如何提升文本处理能力的?如何利用API创建和调用Embedding?我们将一一探讨。

说在前面

主题介绍:本文将详细介绍OpenAI Embedding的基本概念、发展历程、应用场景以及在API中的具体操作,帮助读者深入理解其原理和实际应用。

重要性说明:Embedding技术在文本相似度计算、语义分析、信息检索等各类NLP任务中扮演了关键角色。掌握这项技术不仅能提升文本处理的效率和精准度,还能助力智能应用的开发。

预期内容概述:文章将从以下几个方面展开:

- Define and background of OpenAI Embedding

- Detailed explanation of Embeddings in OpenAI API

- Practical tips for using Embeddings

- Frequently asked questions

- Summary and next steps

关键词背景介绍

定义和基本概念

Embedding是一种将离散的数据(如单词、短语、句子)映射到连续向量空间的方法。简单来说,即将文字信息转化为计算机可以处理的数字格式。在OpenAI的API中,Embedding将输入的文本转化为高维向量,每个向量元素表示文本的某一特征,用以捕捉其语义信息。

历史和发展

语言嵌入技术由来已久。从早期的one-hot编码、TF-IDF,到后来的Word2Vec、GloVe模型,再到目前常用的深度学习模型如BERT、GPT-3等,嵌入技术不断演进。OpenAI的Embedding模型则结合了最新的深度学习进展,以其强大的性能和灵活性在各类应用中崭露头角。

关键词详细解读

OpenAI Embedding在API中的应用

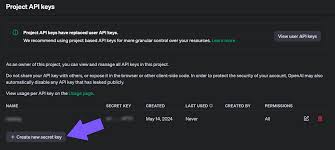

在OpenAI的API中,调用Embedding服务十分方便。以Python为例,首先需要引入openai库并设置API密钥。然后,可以通过简单的API调用获取文本的嵌入向量:

import openai

openai.api_key = "YOUR_API_KEY"

response = openai.Embedding.create(

model="text-embedding-ada-002",

input="OpenAI Embedding的应用"

)

embedding = response['data'][0]['embedding']

print(embedding)

上面的代码段调用了text-embedding-ada-002模型来获取文本”OpenAI Embedding的应用”的嵌入向量。返回的embedding是一个数值向量,可以用于后续的相似度计算、分类或聚类等任务。

实例:文本相似度计算

Embedding向量最直接的应用之一是文本相似度计算。通过计算两个文本Embedding的余弦相似度,可以轻松判断它们的语义相似性。例如:

from sklearn.metrics.pairwise import cosine_similarity

import numpy as np

text1 = "OpenAI是人工智能研究公司。"

text2 = "OpenAI是一家从事人工智能的公司。"

# 获取每个文本的嵌入向量

embedding1 = openai.Embedding.create(model="text-embedding-ada-002", input=text1)['data'][0]['embedding']

embedding2 = openai.Embedding.create(model="text-embedding-ada-002", input=text2)['data'][0]['embedding']

# 计算余弦相似度

similarity = cosine_similarity([embedding1], [embedding2])

print("相似度:", similarity[0][0])

在以上示例中,我们通过余弦相似度来衡量两个文本的相似性,该数值越接近1,表示两个文本语义越相似。

深入实例:文档分析与分类

除了文本相似度计算,Embedding还可以用于更复杂的任务,如文档分类、情感分析等。我们可以通过将文档的Embedding训练分类模型,如SVM、神经网络等,实现高效的自动化处理。

例如,对于一组新闻文本,我们可以先使用Embedding提取其特征向量,然后训练一个简单的分类器来区分不同类别的新闻:

from sklearn.svm import SVC

# 假设我们已经有了一组训练文本和标签

texts = ["科技新闻...", "体育新闻...", "财经新闻..."]

labels = [0, 1, 2] # 三个类别分别为0,1,2

# 获取每个文本的嵌入向量

embeddings = [openai.Embedding.create(model="text-embedding-ada-002", input=text)['data'][0]['embedding'] for text in texts]

# 训练分类器

classifier = SVC()

classifier.fit(embeddings, labels)

# 对新文本进行分类

new_text = "最新的科技产品..."

new_embedding = openai.Embedding.create(model="text-embedding-ada-002", input=new_text)['data'][0]['embedding']

predicted_label = classifier.predict([new_embedding])

print("预测类别:", predicted_label[0])

关键词相关Tips

- 合理选择模型:OpenAI提供了多个不同的Embedding模型,选择适合自己需求的模型能显著提升效果。通常,text-embedding-ada-002是一个通用且强大的选择。

- 微调模型:对于特定任务,需要对预训练模型进行微调,以提升模型在特定领域的表现。

- 数据预处理:清洗和标准化输入文本,包括去除噪声字符、标点符号等,可提升Embedding结果的稳定性。

- 批量处理:对于大规模文本处理,使用批量API调用可以显著提高处理效率。

- 使用向量数据库:将生成的Embedding存储在向量数据库中可快速进行相似度检索和其他复杂计算。

关键词常见问题解答(FAQ)

- Q: 什么是Embedding的主要应用场景?

A: Embedding技术广泛应用于文本相似度计算、文档分类、信息检索、推荐系统等NLP任务中。 - Q: 如何选择合适的OpenAI Embedding模型?

A: 不同模型适用于不同的应用场景和需求。text-embedding-ada-002为通用模型,通常是比较稳妥的选择。 - Q: 使用OpenAI Embedding时应注意什么?

A: 注意数据预处理、模型微调和批量处理的优化,对于大规模数据分析,合理引入向量数据库。 - Q: 怎样确保Embedding结果的稳定性?

A: 确保输入数据的清洗标准化,选择合适的模型进行微调,以及批量API调用的优化。 - Q: OpenAI Embedding是否适用于实时应用?

A: 目前的API调用性能已能满足大多数实时应用的需求,但对于极高实时性要求,需评估API延迟。

总结

通过本文,我们详细探讨了OpenAI Embedding的定义、发展、应用以及在OpenAI API中的实际操作。Embedding技术在NLP任务中具有广泛的应用前景,掌握这项技术不仅能提升文本处理的效率和精准度,还能助力智能应用的开发。我们持续关注这项技术的发展,并期待读者将其应用于各类实际项目中,创造更多价值。