- ChatGPT打不开,专用网络美国海外专线光纤:老张渠道八折优惠。立即试用>

- GPT3.5普通账号:美国 IP,手工注册,独享,新手入门必备,立即购买>

- GPT-4 Plus 代充升级:正规充值,包售后联系微信:laozhangdaichong7。下单后交付>

- OpenAI API Key 独享需求:小额度 GPT-4 API 有售,3.5 不限速。立即购买>

- OpenAI API Key 免费试用:搜索微信公众号:紫霞街老张,输入关键词『试用KEY』

本店稳定经营一年,价格低、服务好,售后无忧,下单后立即获得账号,自助下单 24小时发货。加V:laozhangdaichong7

立即购买 ChatGPT 成品号/OpenAI API Key>>

请点击,自助下单,即时自动发卡↑↑↑

OpenAI Gym是什么

OpenAI Gym是一款用于开发和比较强化学习算法的工具包。它提供了一个统一的接口,让开发者可以对各种环境进行控制和交互,从而可以使用相同的代码和算法在不同的环境中进行测试和评估。通过OpenAI Gym,开发者可以快速构建和训练强化学习模型,并通过模型的性能在不同环境中进行比较。

OpenAI Gym提供了丰富的环境库,包括经典控制问题、Atari 2600游戏等。每个环境都有特定的目标和奖励机制,开发者可以根据自己的需求选择适合的环境进行开发和测试。

了解OpenAI Gym的基本概念和用法对于学习和实践强化学习非常重要,接下来将介绍OpenAI Gym的环境配置和使用方法。

OpenAI Gym的环境库

OpenAI Gym的环境库包含了多个环境,开发者可以选择适合自己需求的环境进行开发和测试。以下是一些常见的环境类型:

- 经典控制问题:包括倒立摆、弹簧振子等。

- Atari 2600游戏:包括乒乓球、坦克大战等经典游戏。

- 连续控制问题:包括机器人控制、汽车模拟等。

- 动态系统:包括振荡器、稳定器等。

每个环境都有其特定的目标和奖励机制。例如,在倒立摆环境中,目标是使杆保持平衡,奖励机制可能是在杆保持平衡的同时,尽量减少用于保持平衡的力。在游戏环境中,目标可能是获得最高的游戏分数,奖励机制可能是击败对手或超越自己的最高分。

OpenAI Gym的环境配置和使用

要使用OpenAI Gym,首先需要安装OpenAI Gym库。可以通过以下方式进行安装:

- 使用pip安装:

pip install gym - 使用conda安装:

conda install -c conda-forge gym

安装完成后,就可以开始使用OpenAI Gym了。使用OpenAI Gym的基本流程如下:

- 导入OpenAI Gym库:

import gym - 创建指定环境:

env = gym.make('env-name'),其中’env-name’是指定环境的名称,根据需要选择合适的环境。 - 初始化环境:

observation = env.reset(),这将返回环境的初始状态。 - 执行动作并观察结果:

action = agent.take_action(observation),agent是开发者定义的强化学习模型,根据当前状态选择适当的动作。 - 更新环境状态:

observation, reward, done, info = env.step(action),将动作应用于环境,并返回更新后的状态、奖励、是否完成以及其他额外信息。 - 重复步骤4和5,直到完成训练或达到指定的终止条件。

通过以上步骤,就可以使用OpenAI Gym进行强化学习的训练和测试了。可以根据需要自定义强化学习模型的算法和策略,以及环境的评估指标和奖励机制。

了解和掌握OpenAI Gym的环境配置和使用方法对于开发和评估强化学习算法非常重要。通过使用OpenAI Gym,开发者可以快速构建和训练强化学习模型,并通过不同环境的性能比较,选择和改进合适的算法和参数。

OpenAI Gym环境配置

OpenAI Gym是一个用于开发和比较强化学习算法的开源工具包。在使用OpenAI Gym之前,需要进行环境配置,包括安装OpenAI Gym库、导入OpenAI Gym库以及选择特定的环境。

安装OpenAI Gym

首先,我们需要安装OpenAI Gym的Python库。可以使用pip命令进行安装:

pip install gym

导入OpenAI Gym

在Python代码中,可以使用import语句导入OpenAI Gym库:

import gym

选择环境

通过调用gym.make()函数,我们可以选择一个特定的环境。例如,我们可以选择LunarLander-v2环境:

env = gym.make('LunarLander-v2')

这样,我们完成了OpenAI Gym环境的配置。接下来,可以利用这个环境进行强化学习算法的开发和测试。

OpenAI Gym基本用法

OpenAI Gym是一个开源的用于开发和比较强化学习算法的工具包。它提供了一系列标准化的环境,使得我们可以更容易地进行强化学习的实验和研究。下面我们来了解一下OpenAI Gym的基本用法。

1. 重置环境

使用env.reset()函数将环境重置为初始状态,并返回初始观测。

- 实例化一个环境对象:

env = gym.make('CartPole-v1') - 通过

reset()函数重置环境:observation = env.reset()

2. 与环境交互

使用env.step()函数与环境进行交互,执行一个动作并返回下一个观测、奖励、是否结束和额外信息。

- 选择一个动作,可以是随机动作:

action = env.action_space.sample() - 通过

step()函数执行动作并获取交互结果:next_observation, reward, done, info = env.step(action) - next_observation:下一个观测,即执行动作后的环境状态

- reward:执行动作获得的奖励

- done:判断当前时刻是否为终止状态

- info:其他额外的信息,用于调试或统计

3. 关闭环境

使用env.close()函数关闭环境,释放资源。

- 关闭环境:

env.close()

通过上述步骤,我们可以完整地使用OpenAI Gym中的环境进行实验。下面是一个完整的示例:

import gym

# 实例化一个环境对象

env = gym.make('CartPole-v1')

# 重置环境

observation = env.reset()

# 与环境交互

for _ in range(100):

# 选择一个随机动作

action = env.action_space.sample()

# 执行动作并获取交互结果

next_observation, reward, done, info = env.step(action)

# 如果当前时刻为终止状态,则重置环境

if done:

env.reset()

# 关闭环境

env.close()

以上是OpenAI Gym的基本用法,通过使用reset()函数重置环境,step()函数与环境交互,以及close()函数关闭环境,我们可以方便地进行强化学习的实验和研究。

OpenAI Gym的评估方法

OpenAI Gym是一个用于开发和比较强化学习算法的工具包。对于开发强化学习模型,评估模型的性能是至关重要的。 OpenAI Gym提供了评估方法,可以帮助开发人员对模型进行定量评估和改进。

定义评估函数

在评估模型之前,首先需要定义一个评估函数。这个函数将以模型和环境作为输入,并返回模型在环境中的表现。评估函数的输入还包括以下参数:

- n_eval_episodes:评估模型的时候运行的回合数

- deterministic:如果设置为True,表示模型的行为是确定的,如果设置为False,表示模型的行为是随机的。

评估函数的返回结果可以是模型在多次运行后的平均奖励和奖励的标准差。以下是一个示例评估函数的代码:

def evaluate_policy(model, env, n_eval_episodes, deterministic=True):

rewards = []

for _ in range(n_eval_episodes):

episode_reward = 0

obs = env.reset()

done = False

while not done:

action = model.predict(obs)

obs, reward, done, _ = env.step(action)

episode_reward += reward

rewards.append(episode_reward)

mean_reward = np.mean(rewards)

std_reward = np.std(rewards)

return mean_reward, std_reward

评估模型

使用评估函数对模型进行评估非常简单。只需要调用评估函数,并将模型、环境和其他参数作为输入。

mean_reward, std_reward = evaluate_policy(model, env, n_eval_episodes=10, deterministic=True)

结果分析

评估函数返回的平均奖励和奖励的标准差是评估模型性能的重要指标。可以根据这些指标对不同模型进行比较和分析。如果模型的平均奖励较高且标准差较低,表示模型的性能较好且稳定。如果模型的平均奖励较低且标准差较高,可能需要进行优化和改进。

根据评估结果,可以进一步分析模型的性能并制定优化策略。可能需要调整模型的超参数、改进模型的结构或增加训练数据等。通过不断迭代和改进,可以提高模型的性能和稳定性。

总之,OpenAI Gym提供了评估模型性能的方法,通过定义评估函数和分析评估结果可以帮助开发人员优化和改善强化学习模型。

结语

通过OpenAI Gym,开发者可以轻松地使用强化学习算法进行建模和开发,并在不同的环境中测试和评估模型的性能。本文介绍了OpenAI Gym的基本概念和用法,包括环境配置、基本用法和评估方法。希望这些内容对初学者学习和实践强化学习有所帮助。

OpenAI Gym简介

OpenAI Gym是一个开放式人工智能平台,旨在为开发者提供一个标准化的强化学习环境,方便开发者进行强化学习算法的研究和开发。它包含了一系列的预定义的环境,开发者可以在这些环境中测试自己的强化学习模型,并通过评估模型在不同环境中的性能来优化模型。

OpenAI Gym提供了丰富的工具和接口,使开发者能够轻松地创建、配置和使用强化学习环境。它支持多种编程语言,包括Python、Java和C++等,使开发者能够使用自己熟悉的语言进行开发。

在进行强化学习之前,开发者需要首先安装和配置OpenAI Gym。安装过程相对简单,通过一些简单的命令即可完成。一旦安装完成,开发者就可以使用OpenAI Gym提供的预定义环境进行训练和测试。

在使用OpenAI Gym进行强化学习之前,开发者需要了解几个基本概念。首先是环境(Environment),环境定义了强化学习任务的状态空间、行动空间和奖励机制。在每个时间步上,智能体(Agent)会观察到当前状态,并根据策略(Policy)选择一个动作。环境会根据选择的动作计算奖励,并更新状态。智能体的目标是通过与环境的交互来最大化累积奖励。OpenAI Gym提供了一系列的环境,开发者可以根据自己的需求选择合适的环境。

除了基本概念外,开发者还需要了解如何在OpenAI Gym中进行训练和测试。训练是通过学习算法来优化智能体的行为策略,使其能够在特定环境中获得最大化的奖励。测试是通过评估智能体在一系列环境中的性能,以检验模型的效果。OpenAI Gym提供了一些评估方法,包括平均奖励和最大奖励等,可以帮助开发者评估模型的性能。

OpenAI Gym的基本用法

- 安装配置:在使用OpenAI Gym之前,需要先进行安装和配置。具体步骤可以参考OpenAI Gym的官方文档或相关教程。

- 环境选择:OpenAI Gym提供了多种环境供开发者选择,包括经典控制、Atari游戏和Robotics等。开发者可以根据自己的需求选择合适的环境。

- 智能体与环境交互:使用OpenAI Gym,开发者可以编写代码来创建智能体,并与环境进行交互。智能体在每个时间步上观察环境的状态,并根据策略选择一个动作。环境会根据选择的动作计算奖励,并更新状态。智能体的目标是通过与环境的交互来最大化累积奖励。

- 训练模型:通过学习算法,开发者可以训练智能体的行为策略,使其在特定环境中获得最大化的奖励。训练过程通常包括初始化模型参数、采取动作、计算奖励和更新模型等步骤。

- 测试模型:训练完成后,开发者可以使用训练好的模型在一系列测试环境中进行测试。测试过程通常包括对模型的行为进行观察和评估,以检验模型的效果。

OpenAI Gym的评估方法

OpenAI Gym提供了多种评估方法,用于评估模型在不同环境中的性能。以下是常用的几种评估方法:

- 平均奖励(Average Reward):计算智能体在一系列环境中的平均奖励。平均奖励越高,说明模型的性能越好。

- 最大奖励(Maximum Reward):筛选出智能体在一系列环境中获得最大奖励的情况,用于评估模型的最佳性能。

- 奖励曲线(Reward Curve):绘制智能体在训练过程中的奖励曲线,通过观察曲线的变化,可以了解模型的训练进展和性能提升。

通过OpenAI Gym,开发者可以轻松地使用强化学习算法进行建模和开发,并在不同的环境中测试和评估模型的性能。它提供了丰富的工具和接口,使开发者能够轻松地创建、配置和使用强化学习环境。同时,OpenAI Gym还提供了多种评估方法,帮助开发者评估模型的性能。无论是初学者还是有经验的开发者,都可以从OpenAI Gym中受益,并加快强化学习算法的研究和开发过程。

openai gym教程的常见问答Q&A

什么是强化学习实战——OpenAI Gym环境配置+实战演示(win10)?

强化学习实战——OpenAI Gym环境配置+实战演示(win10)是一篇介绍如何配置OpenAI Gym环境,并通过实战演示解决问题的教程。

- 在教程中,作者将提供关于在win10操作系统下配置OpenAI Gym环境的详细步骤。

- 作者还将通过实例演示如何使用OpenAI Gym环境解决问题。

成为AI大师的第一步:OpenAI Gym教程-147SEO是什么内容?

成为AI大师的第一步:OpenAI Gym教程-147SEO是一篇介绍使用OpenAI Gym工具包学习强化学习的教程。

- 这篇教程将阐述强化学习作为前沿技术在各个领域的应用。

- 通过学习OpenAI Gym工具包,读者可以掌握强化学习的基本概念和应用方法。

如何通过evaluate_policy函数对模型进行评估?

通过evaluate_policy函数,可以对强化学习模型进行评估。

- 首先,需要创建一个用于评估模型的环境,可以使用gym.make函数创建指定的环境。

- 接着,使用evaluate_policy函数对模型在评估环境中的性能进行评估。

- 可以指定评估的次数,设置deterministic参数为True表示评估过程中不使用随机策略。

- 评估完成后,将得到平均奖励和奖励的标准差。

示例:

eval_env = gym.make('LunarLander-v2')

mean_reward, std_reward = evaluate_policy(model, eval_env, n_eval_episodes=10, deterministic=True)

print(f"mean_reward: {mean_reward}, std_reward: {std_reward}")

如何成为AI大师?

要成为AI大师,以下是一些步骤和建议:

- 研究和学习人工智能的基本概念和原理。

- 深入了解强化学习算法和工具,如OpenAI Gym。

- 通过实践,使用OpenAI Gym等工具包解决现实世界的问题。

- 参与人工智能相关的项目和竞赛,积累实战经验。

- 持续学习和跟踪最新的人工智能研究和应用。

什么是OpenAI Gym?

OpenAI Gym是一款用于开发和比较强化学习算法的工具包。

- 它提供了一系列标准化的环境和任务,供开发者测试和评估强化学习算法。

- 使用OpenAI Gym,开发者可以快速搭建和测试自己的强化学习模型,加速模型的研发过程。

- OpenAI Gym还提供了丰富的文档和教程,便于初学者快速上手。

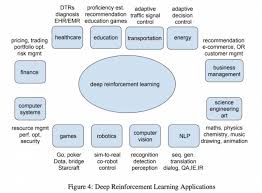

强化学习在哪些领域应用广泛?

强化学习在很多领域都有广泛的应用:

- 机器人控制:强化学习可用于训练机器人学习如何在复杂环境中执行任务。

- 游戏AI:强化学习可用于训练游戏AI,使其能够自动学习和改进游戏策略。

- 金融交易:强化学习可用于开发自动化的交易系统,帮助进行金融交易决策。

- 智能交通:强化学习可用于优化交通信号灯控制,提高交通效率。

- 自然语言处理:强化学习可用于开发智能对话系统,改进对话生成和理解能力。

参考链接:

了解更多关于 ChatGPT Plus和免费版的区别 及哪个更适合您。