加我微信:laozhangdaichong7。确保你能用上 ChatGPT 官方产品和解决 Plus 升级的难题。本站相关服务↓

- ChatGPT一直转圈,专用网络美国海外专线光纤:老张渠道八折优惠。立即试用>

- GPT3.5普通账号:美国 IP,手工注册,独享,新手入门必备,立即购买>

- GPT-4 Plus 代充升级:正规充值,包售后联系微信:laozhangdaichong7。下单后交付>

- OpenAI API Key 独享需求:小额度 GPT-4 API 有售,3.5 不限速。立即购买>

- OpenAI API Key 免费试用:搜索微信公众号:紫霞街老张,输入关键词『试用KEY』

下单后立即获得账号,自助下单 24小时发货。很稳定,哪怕被封免费换新,无忧售后。

立即购买 ChatGPT 成品号/OpenAI API Key>>

请点击,自助下单,即时自动发卡↑↑↑

ChatGPT训练数据的来源和构建方法

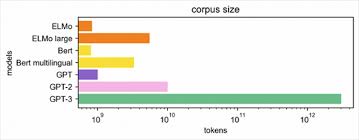

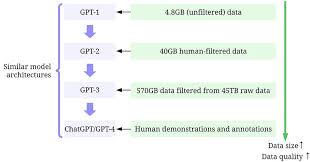

ChatGPT是一种用于训练自然语言处理任务的语言模型,其训练数据是通过收集、整理和预处理大规模的互联网文本数据集构建的。下面将从数据来源、数据预处理、数据采样等方面对ChatGPT的训练数据集进行详细介绍。

数据来源

ChatGPT的训练数据来源广泛,既包括了通用领域的文本,也包括了特定领域的文本,如科技、体育、时政等。主要的数据来源包括:

- 互联网文本数据:OpenAI收集了大量的互联网文本数据,包括网页、论坛、博客等。

- 维基百科:维基百科是个人和专业人士贡献的一部分许可自由的网上百科全书,其中的内容被用作ChatGPT的训练数据之一。

- 新闻:OpenAI从新闻网站和新闻数据库中获取了大量的新闻文章,用于训练ChatGPT模型。

- 社交媒体:社交媒体平台上的文本数据也被用作ChatGPT的训练数据,包括推特、微博等。

数据构建方法

ChatGPT的训练数据构建过程包括数据收集、整理和预处理等步骤。

- 数据收集和整理:OpenAI使用了爬虫技术从互联网上收集了大量的文本数据,并对这些数据进行整理和去重处理,以保证数据的多样性和质量。

- 预处理:为了使数据适合作为ChatGPT的训练数据,OpenAI对数据进行了预处理,包括分词、去除标点符号和停用词等操作。

ChatGPT的数据构建方法确保了模型在训练过程中能够接触到各种不同领域的文本数据,从而提高了模型的语言理解和生成能力。

为了更好地理解ChatGPT的训练数据集构建方法,可以参考如下链接:如何训练ChatGPT并应用于个人数据。这篇文章详细介绍了ChatGPT的训练数据集构建方法,包括了无监督文本数据的收集和整理过程。

特定领域特点

ChatGPT的训练数据集通过收集来自多个来源的大量文本数据,使得模型具有了一定的对多领域的理解能力。然而,由于训练数据的来源广泛,模型在特定领域的理解和生成能力可能相对较弱。因此,如果需要在特定领域应用ChatGPT,可能需要针对该领域的数据进行微调或自定义训练。

总之,ChatGPT的训练数据集来源广泛,数据构建方法科学有效。它通过大规模的互联网文本数据来训练模型,从而使得模型具有更好的语言理解和生成能力。不过,在特定领域应用时,可能需要额外的数据处理和训练步骤来提升模型在该领域的性能。

ChatGPT训练数据的来源

ChatGPT的训练数据主要来自于互联网上的文本数据,包括维基百科、新闻、社交媒体等。 这些数据集非常庞大,通常需要通过爬虫和其他方式进行收集和整理。 在训练ChatGPT模型时,使用更多更高质量的训练数据可以提高模型的性能和准确性。 同时,训练数据的多样性也对模型的性能和泛化能力有重要影响。

互联网文本数据

ChatGPT使用了互联网上各种类型的文本数据作为训练数据,涵盖了通用领域的文本,如网页、书籍、新闻文章等。

维基百科

维基百科是ChatGPT训练数据的重要来源之一,其中包含了丰富的知识和信息,可以为ChatGPT提供广泛的语境和背景。

新闻

新闻信息也是ChatGPT训练数据的重要组成部分。从新闻报道中获取的语言数据可以使ChatGPT对当前事件和热点话题保持敏感,并具备一定的时效性。

社交媒体

社交媒体平台,如Twitter、Facebook等,提供了大量的用户生成内容作为ChatGPT训练数据的来源。这些数据反映了人们的真实对话和交流,使ChatGPT更具有现实世界的语言能力。

ChatGPT训练数据的构建方法

ChatGPT的训练数据集的构建过程包括数据收集和整理、爬虫技术和预处理。

数据收集和整理

在构建ChatGPT的训练数据集之前,需要收集大量的文本数据作为基础。这一过程需要耗费大量的计算资源和数据收集工作。数据收集的目标是获取具有多样性和广泛性的文本数据,以便能够覆盖不同领域和语境。

为了获得互联网上的文本数据,常常需要使用爬虫技术从各种源站点爬取数据。爬虫技术需要技术人员编写爬虫程序,并进行必要的数据清洗和去重。

预处理

在数据收集完毕后,还需要进行预处理工作,以便模型能够更好地理解和处理数据。预处理的步骤包括对数据进行去噪、分词、标记化等处理。

构建ChatGPT训练数据集的方法和原理,以及无监督文本数据在训练数据集中的应用,都是构建ChatGPT语言模型的重要部分。

目前,关于ChatGPT训练数据集构建的详细细节并不多见,但可以通过深入研究ChatGPT论文和开发者公开的相关信息,了解到一些关键的知识。

总的来说,ChatGPT的训练数据集的构建是一个复杂而耗时的过程,需要数据科学家和工程师的共同努力,以提供优质和多样性的训练数据集,以便ChatGPT能够生成准确和有用的回答。

chatgpt训练数据的常见问答Q&A

ChatGPT的训练数据是什么?

ChatGPT的训练数据是通过收集和整理互联网上的大量文本数据来构建的。

ChatGPT的训练数据主要来源于维基百科、新闻、社交媒体等各种类型的文本数据。这些数据集非常庞大,通常需要通过爬虫和其他方式进行收集和整理。

在训练ChatGPT模型时,使用更多更高质量的训练数据可以提高模型的性能和准确性。训练数据的多样性也对模型的性能和泛化能力有重要影响。

ChatGPT的训练数据集是如何构建的?

ChatGPT的训练数据集是由多个语料库组成,包括各种类型的无监督文本数据。

这些语料库包括网页、书籍、新闻文章等。数据集同时包含通用领域的文本和特定领域的文本,如科技、体育、时政等。

在将这些数据集用于训练ChatGPT之前,需要对其进行预处理,如句子分割、标记化等。

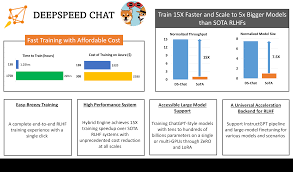

构建ChatGPT的训练数据集的过程需要大量的计算资源和数据收集工作。

ChatGPT训练数据的来源和构建过程

ChatGPT训练数据的来源包括各种无监督文本数据集,如维基百科、新闻、社交媒体等。

构建ChatGPT训练数据集的过程可以通过收集和整理互联网上的大量文本数据来实现。这一过程常常需要使用爬虫和其他工具来收集数据,并进行一系列的预处理操作。

在训练数据预处理阶段,通常会进行数据清洗、分词、去除停用词等操作以及其他一些特定的处理流程,以准备好适合用于训练的数据。

ChatGPT训练数据的构建过程需要耗费大量的时间和工作量,但这些数据对于模型的性能提升具有重要意义。

【了解更多】:ChatGPT训练数据的来源和构建过程