加我微信:laozhangdaichong7。确保你能用上 ChatGPT 官方产品和解决 Plus 升级的难题。本站相关服务↓

- ChatGPT一直转圈,专用网络美国海外专线光纤:老张渠道八折优惠。立即试用>

- GPT3.5普通账号:美国 IP,手工注册,独享,新手入门必备,立即购买>

- GPT-4 Plus 代充升级:正规充值,包售后联系微信:laozhangdaichong7。下单后交付>

- OpenAI API Key 独享需求:小额度 GPT-4 API 有售,3.5 不限速。立即购买>

- OpenAI API Key 免费试用:搜索微信公众号:紫霞街老张,输入关键词『试用KEY』

下单后立即获得账号,自助下单 24小时发货。很稳定,哪怕被封免费换新,无忧售后。

立即购买 ChatGPT 成品号/OpenAI API Key>>

请点击,自助下单,即时自动发卡↑↑↑

ChatGPT模型训练指南

ChatGPT模型训练是一种需要收集大量的文本数据,然后使用特定的方法和技术进行模型预训练和微调的过程。下面将介绍训练ChatGPT模型的四个主要阶段,以及准备数据集、训练过程中的关键步骤与注意事项。

准备数据集

- 收集大规模的对话数据:为了训练ChatGPT模型,需要收集足够数量的对话数据。这些数据可以包括聊天记录、对话日志等。

- 数据清洗和预处理:在收集到的对话数据中,可能存在噪音和无效信息。因此,需要对数据进行清洗和预处理,以去除无用的内容,并确保数据质量。

- 格式化数据集:将清洗过的对话数据进行格式化,以便适应ChatGPT模型的输入要求。通常,可以将对话拆分为问题和回答的对,或者将多轮对话组成一个完整的对话样本。

训练过程及关键步骤

训练ChatGPT模型一般可以分为以下四个主要阶段:

无监督预训练

- 基于语言模型的预训练:使用大规模的无监督数据集,在ChatGPT模型上进行语言模型的预训练。这一阶段的目标是让模型学会理解和生成人类对话的文本。

- Transformer结构应用:ChatGPT模型采用了Transformer结构,该结构能够帮助模型捕捉长距离的依赖关系,提高对话生成的效果。

监督微调

- 收集有标签的对话数据:为了进行监督微调,需要收集与ChatGPT模型任务相关的有标签对话数据。

- 定义任务和指标:根据具体应用场景,定义任务的输入和输出格式,并选择合适的评估指标来度量模型在任务上的性能。

- 使用标注数据进行微调:将有标签的对话数据与ChatGPT模型结合,进行监督微调,以使模型在特定任务上达到更好的效果。

指令微调

- 指令生成与示范学习:通过人类示范和偏好比较的方式,对ChatGPT模型进行强化学习优化。模型观察和学习人类示范的方式进行强化学习,以指导模型生成更符合人类期望的对话。

- 反馈机制设计:设计合适的反馈机制,使ChatGPT模型能够根据生成结果的质量进行优化。

- 交互式微调:在与真实用户进行交互的过程中,逐步改进ChatGPT模型的表现,以便更好地满足用户的需求。

总结

通过以上四个主要阶段的训练过程,可以得到一个自定义的ChatGPT模型,用于生成模拟对话的文本。在整个训练过程中,数据集的大小和多样性、无监督预训练、监督微调和指令微调等步骤都对模型的性能和效果起到重要作用。

更多关于ChatGPT模型训练的内容,可以参考以下链接:ChatGPT训练成本与效果对比分析。

什么是ChatGPT模型训练

ChatGPT模型是OpenAI官方推出的自定义API使用方式,旨在满足用户在特定业务情境下的智能问答应用需求。该模型是基于预训练的GPT架构创建的语言模型,利用大规模的无标签文本进行训练,以学习语言的统计规律和上下文关系。ChatGPT的训练数据包括了丰富而多样的聊天记录和对话日志,使其能够生成与人类对话非常相似的内容。

为了训练ChatGPT模型,一般需要经过两个阶段:预训练和监督微调。

1. 预训练

在预训练阶段,模型使用大规模的无标签文本进行训练,通过学习文本数据的统计规律和上下文关系来生成模型的初始参数。预训练模型的目标是尽可能准确地预测出给定上下文中的下一个词语。通过预训练,模型能够学习到丰富的语言知识和模式,为后续的微调提供基础。

2. 监督微调

在监督微调阶段,使用带标签的特定领域数据来微调预训练模型。这些带标签的数据通常是由人工创建或整理的,用于训练模型在特定领域的准确性和相关性。通过与特定领域数据的对齐,模型可以更好地理解和回答与该领域相关的问题。

在ChatGPT的模型训练中,使用了指令学习和人工反馈强化学习的方法。指令学习旨在通过给定一些示例指令和回复样本,让模型学会按照指令给出相应的回复。随后,在人工反馈强化学习中,通过与人类专家进行互动,模型逐渐得到反馈和指导,以提高其回答的质量和准确性。

ChatGPT模型的应用领域

ChatGPT模型可以应用于多个领域,帮助解决各种智能问答和对话生成任务。以下是一些ChatGPT模型的典型应用场景:

1. 机器人客服

ChatGPT模型可以用于开发智能机器人客服系统,通过对话生成与用户进行互动,解答用户的问题和需求。其灵活性和适应性使得机器人能够提供个性化、高效的客户服务体验。

2. 虚拟助手

ChatGPT模型还可用于构建虚拟助手,通过与用户的对话,执行各种任务和操作,如日程安排、提醒、查询和推荐等。模型能够理解用户的意图并提供相应的回答和建议。

3. 智能教育

ChatGPT模型在教育领域的应用也呈现出广阔的前景。它可以作为智能教学助手,帮助学生解答问题、提供学习资源和指导。同时,通过与模型的对话,学生可以进行自主学习和知识探索。

4. 聊天机器人

ChatGPT模型可以被用于开发聊天机器人,为用户提供陪伴、娱乐和情感支持等功能。聊天机器人可以通过对话和用户建立情感连接,提供个性化的交流和互动。

ChatGPT模型训练涉及大量的聊天记录和对话日志,这些数据主要来源于各种公开和私有的渠道。为了保护用户隐私和敏感信息,OpenAI采取了一系列隐私保护措施,例如对训练数据进行去标识化和匿名化处理,并严格遵守法律和道德准则。

了解更多关于ChatGPT训练数据来源和隐私保护措施,您可以参考ChatGPT的训练数据主要来源与隐私保护措施。

训练ChatGPT模型的四个主要阶段

ChatGPT模型的训练过程分为四个主要阶段:预训练、有监督微调、奖励建模和强化学习。下面将详细介绍每个阶段的内容:

预训练

预训练是ChatGPT模型训练的第一阶段。在预训练阶段,模型使用大规模的未标注文本数据进行训练。这些文本数据可以包括互联网上的新闻、文章、维基百科等大量文本内容。预训练的目标是让模型学习到一些基础的语言知识和表示能力。

预训练使用了Transformer结构,这是一种基于自注意力机制的深度神经网络结构。Transformer在处理自然语言时表现出了很好的效果,因此被广泛应用于ChatGPT模型的训练中。

具体而言,预训练的过程是通过训练模型来填补一些被遮盖的单词。模型在处理每个单词时,通过上下文来预测被遮盖的单词是什么。这个过程可以帮助模型学习到单词之间的关联性,以及如何利用上下文来理解句子的意思。

有监督微调

有监督微调是ChatGPT模型训练的第二阶段。在这个阶段,模型使用标注的对话数据进行微调。标注的对话数据包括了输入问题和模型期望输出的回答。

有监督微调的目标是让模型能够生成符合预期的回答。通过使用标注数据进行微调,可以提高模型的输出质量,并使其更好地符合人类的需求。

奖励建模

奖励建模是ChatGPT模型训练的第三阶段。在这个阶段,模型通过强化学习方法进行训练。强化学习是通过奖励和惩罚的方式来指导模型生成回答。

在奖励建模阶段,模型会根据给定的奖励信号重新调整自己的参数,以生成更高质量的回答。这个过程可以在一定程度上提升模型的表现,使其能够生成更符合用户需求的回答。

强化学习

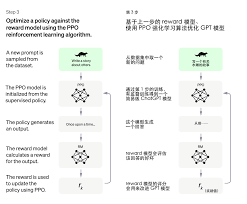

强化学习是ChatGPT模型训练的最后阶段。在这个阶段,模型使用PPO(Proximal Policy Optimization)算法进行训练。

强化学习的目标是让模型通过与环境的交互学习到最佳的策略。模型会通过与虚拟用户进行对话来进行训练,不断尝试不同的回答方式,并通过奖励和惩罚信号来调整自己的参数。

通过强化学习,模型可以不断改进自己的表现,使其能够生成更加准确和合理的回答。

参考链接:ChatGPT的预训练数据规模揭秘(chatgpt的预训练数据量)

数据集获取与预处理

数据集的获取和预处理是训练ChatGPT模型的重要步骤。在获取数据集时,可以选择公共数据集或自建数据集,并针对数据集的规模进行考虑。在进行数据预处理时,需要进行数据清洗和去重,同时进行数据格式转换和标注。

获取数据集的途径和注意事项

在获取数据集时,有一些途径和注意事项需要注意:

- 公共数据集和自建数据集的选择:可以选择使用公共数据集,如社交媒体数据、聊天记录等,也可以自建数据集,根据自身需求收集数据。

- 数据集规模对模型准确性的影响:数据集的规模会对模型的准确性产生影响,通常来说,更大规模的数据集可以提高模型的准确性。

数据预处理步骤

数据预处理是数据训练的重要步骤,包括以下几个方面:

- 数据清洗和去重:在数据预处理中,需要进行数据的清洗和去重操作,确保数据的质量和准确性。

- 数据格式转换和标注:根据数据的实际情况,可能需要进行数据格式转换和标注操作,以便于训练模型。

在对ChatGPT模型进行训练之前,需要对数据集进行以上预处理步骤,以确保数据的质量和准确性。

具体的预处理步骤和注意事项可以参考ChatGPT训练过程详解。

训练过程及关键步骤

在训练ChatGPT模型的过程中,主要包括准备训练数据、预训练、有监督微调、奖励建模和强化学习等关键步骤。下面将详细介绍这些步骤以及它们在模型训练中的作用。

准备训练数据

准备数据是训练ChatGPT模型的第一步。为了获得高质量的训练数据,可以收集大量的对话数据作为训练数据集。这些对话数据可以是公开的语料库,也可以是自定义的私有数据。

对于训练数据的数量,研究表明增加训练示例数量可以提高模型的质量。因此,收集更多的对话数据有助于提高ChatGPT模型的性能。

在准备训练数据时,还可以使用OpenAI提供的工具进行数据验证和处理。这些工具可以帮助检测和解决数据中的问题,确保数据的质量和一致性。

预训练

预训练是训练ChatGPT模型的第二个阶段。在预训练阶段,模型会根据大量的文本数据进行学习,以获得对语言的理解能力。

预训练阶段的操作和目标是通过Transformer结构对文本进行建模。Transformer是一种常用的神经网络结构,在自然语言处理任务中表现出色。通过预训练,ChatGPT模型可以学习到一些通用的语言规律和语义表示。

有监督微调

有监督微调是训练ChatGPT模型的第三个阶段。在这个阶段,使用标注数据优化模型的性能,使其适应特定的任务需求。

有监督微调的流程和方法包括使用预处理的数据集进行模型训练,并考虑使用预训练的语言模型进行微调。通过监控训练过程中的损失和性能指标,可以对模型进行优化和调整,以使其在特定任务上表现更好。

奖励建模

奖励建模是训练ChatGPT模型的第四个阶段。在这个阶段,利用增强学习的方法鼓励模型生成高质量的内容。

奖励建模阶段的作用是通过构建训练样本来训练一个反应预测内容效果的奖励模型(RM)。通过奖励模型的打分来指导模型生成高质量的内容。

这个阶段是为了确保ChatGPT模型能够根据用户输入生成准确、有用和相关的回复。

强化学习

强化学习是训练ChatGPT模型的最后一个阶段。在这个阶段,使用PPO(Proximal Policy Optimization)算法进行强化学习训练。

强化学习在模型训练中的作用是通过不断与环境交互,从而改善模型的性能。模型可以通过尝试不同的动作来探索环境,并通过奖励和惩罚机制来调整模型的行为。

通过强化学习,ChatGPT模型可以逐步优化和改进回复的质量,提供更好的用户体验和满足用户需求。

综上所述,训练ChatGPT模型的关键步骤包括准备训练数据、预训练、有监督微调、奖励建模和强化学习。这些步骤相互配合,可以让ChatGPT模型逐步提升其准确性和智能性。

参考链接:ChatGPT训练流程图详解及生成方法

chatgpt训练模型的常见问答Q&A

CHATGPT是什么?

CHATGPT是一个人工智能(AI)语言生成模型,用于自动生成文章、对话、摘要等自然语言文本。

CHATGPT是Open AI公司发布的一个基于自回归(autoregressive)语言模型的算法,它采用了transformer结构,通过训练过程从大量无监督文本数据中学习和生成文本。CHATGPT可以用于多种应用,比如虚拟助手、聊天机器人、智能问答等。

CHATGPT训练数据解密:参考链接:ChatGPT训练数据解密:来源和构建方式

如何训练ChatGPT模型?

为了训练自己的ChatGPT模型,您可以按照以下步骤进行:

第一步:获取数据集。

要训练ChatGPT模型,您需要收集大量对话数据作为训练数据。可以从公共数据集中获取数据,也可以自行创建数据集。数据集的大小和多样性对模型的准确性有影响。

第二步:数据预处理。

在训练之前,需要对数据集进行预处理。预处理包括句子分割、文本清洗、去除噪声等步骤,以使数据适合模型训练。

第三步:模型训练。

使用预处理的数据集进行模型训练。可以选择将预训练的语言模型作为初始模型,然后进行微调训练以提高性能。训练过程中可以监控训练损失和性能指标,并进行适当的调整。

第四步:评估训练效果。

在训练完成后,可以对训练的ChatGPT模型进行评估,检查其在测试集上的性能表现,并对模型进行调优。

ChatGPT的训练过程有哪些阶段?

ChatGPT的训练过程主要分为四个阶段:

1. 预训练:

在预训练阶段,模型会使用大量无标签的文本数据进行训练,以学习语言的统计规律和上下文关系。预训练的目标是生成模型的初始参数。

2. 有监督微调:

在有监督微调阶段,使用带标签的数据对模型进行微调,以提高模型在特定任务上的性能。有监督微调可以进一步提高模型的准确性和适应性。

3. 奖励建模:

奖励建模是采用了人类示范和偏好比较的方法来指导模型行为,通过对模型生成的回答进行评分,并使用强化学习优化模型的效果。

4. 强化学习:

在强化学习阶段,通过与环境的交互学习和优化模型的行为策略,以最大化预设的奖励信号。这个阶段可以进一步提升模型的表现和智能性。