加我微信:laozhangdaichong7。确保你能用上 ChatGPT 官方产品和解决 Plus 升级的难题。本站相关服务↓

- ChatGPT一直转圈,专用网络美国海外专线光纤:老张渠道八折优惠。立即试用>

- GPT3.5普通账号:美国 IP,手工注册,独享,新手入门必备,立即购买>

- GPT-4 Plus 代充升级:正规充值,包售后联系微信:laozhangdaichong7。下单后交付>

- OpenAI API Key 独享需求:小额度 GPT-4 API 有售,3.5 不限速。立即购买>

- OpenAI API Key 免费试用:搜索微信公众号:紫霞街老张,输入关键词『试用KEY』

下单后立即获得账号,自助下单 24小时发货。很稳定,哪怕被封免费换新,无忧售后。

立即购买 ChatGPT 成品号/OpenAI API Key>>

请点击,自助下单,即时自动发卡↑↑↑

ChatGPT训练流程详解

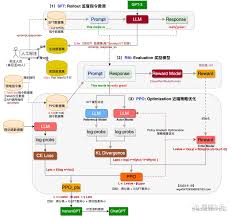

ChatGPT是OpenAI推出的一种基于深度学习的人工智能技术,其主要的功能是模拟人类的对话和思维过程,类似于一个人工智能聊天机器人。ChatGPT的训练过程包括两个阶段:预训练和微调。

预训练阶段

预训练是指通过大规模的无监督学习,让ChatGPT学习语言的一般规律和语义理解能力。下面是预训练阶段的具体流程:

- 数据准备:在预训练阶段,需要准备大量的文本数据作为训练样本。这些文本数据可以来自互联网上的各种资源,比如网页内容、书籍、新闻文章等。文本数据要尽可能多样化,涵盖各种不同的主题和语境。

- 模型设计:在预训练阶段,常用的模型结构是基于Transformer架构。Transformer是一种基于自注意力机制的模型,可以有效地处理语言序列之间的长距离依赖关系。

- 模型训练:使用预先准备好的大规模文本数据对ChatGPT模型进行训练。训练过程中,ChatGPT会逐步学习语言的规律和语义理解能力,并通过反馈机制不断优化模型的参数。

微调阶段

微调是指在预训练完成后,通过使用特定的目标任务数据对ChatGPT进行有监督学习,进一步优化模型的能力。微调阶段的流程如下:

- 监督微调:在监督微调阶段,需要为ChatGPT提供有标签的数据,来指导模型在特定任务上的学习。这些有标签的数据可以是人工标注的对话数据,或者是其他类型的标注数据,比如问题-回答对。

- 奖励建模:在奖励建模阶段,通过构建一个反应预测内容效果的奖励模型(RM),来训练ChatGPT生成更合适的回复。奖励模型会对ChatGPT生成的回复进行评分,根据评分情况来指导ChatGPT的训练。

- 强化学习:在强化学习阶段,让ChatGPT与其他ChatGPT模型进行对话,并通过比较不同回复的效果来调整模型的生成策略。强化学习可以帮助ChatGPT学习生成更合适的回复,并改进对话交互的质量。

评估与优化

在ChatGPT训练流程中,评估与优化是一个重要的环节,用于判断训练过程中模型的性能,并对模型进行调优。具体步骤如下:

- 模型评估:通过使用一些评价指标,如BLEU评分、人类评估等,对ChatGPT的输出结果进行评估。评估的目的是判断模型生成的回复是否合理、流畅,并具有语义连贯性。

- 超参数调优:在模型训练过程中,通过调整一些关键的超参数,比如学习率、批大小等,来提高模型的性能。超参数调优是一个迭代的过程,需要不断尝试不同的参数组合,找到最佳的超参数设置。

通过上述训练流程,ChatGPT可以逐步学习语言的规律和语义理解能力,并生成更合适的回复。欲了解更多关于ChatGPT训练流程的细节,可参考ChatGPT的训练数据量解析及开源模型分享。

概述

ChatGPT是一种基于深度学习的对话模型,由OpenAI开发。它经过预训练、微调和强化学习这三个阶段的训练过程,可以生成具有上下文感知能力的自然语言回答。下面将对ChatGPT的训练流程和强化学习算法进行详细介绍。

ChatGPT的训练流程

ChatGPT的训练过程主要包括以下四个阶段:

- 预训练:在预训练阶段,使用大规模的文本数据集对模型进行初始训练。这些数据集可以是从互联网上收集的开放领域的文本数据,例如维基百科、网页文章和书籍等。预训练使得ChatGPT模型能够学习到丰富的语言知识和语言模式。

- 有监督微调:在有监督微调阶段,使用人工标注的对话数据集对模型进行微调。这些对话数据集包含了用户的对话和对应的回答,可以来自各种渠道,如社交媒体、聊天记录等。通过在这些对话数据上进行微调,模型可以学习到更准确的对话回答。

- 奖励建模:在奖励建模阶段,使用强化学习算法对模型进行训练,使其能够根据预设的奖励信号来生成更合理、流畅的回答。在这个阶段,OpenAI通过与人类操作员进行互动来提供即时的奖励反馈,指导模型生成更好的回答。

- 强化学习:在强化学习阶段,模型通过与自身进行对话,进行自我对话训练。这个过程有点类似于人类在头脑中对话的过程,模型根据之前生成的回答和用户的对话输入进行对话,并通过奖励信号指导自我对话的生成过程。这个阶段的训练可以进一步提升模型的表现。

ChatGPT的训练过程中,采用了强化学习算法来提高模型的表现。通过预训练和微调,模型可以学习到丰富的语言知识和对话模式。而强化学习阶段则通过与人类操作员和自身的对话训练,使模型能够生成更合理、流畅的对话回答。

ChatGPT训练过程中的强化学习算法

在ChatGPT的强化学习训练过程中,采用了基于奖励建模的方法。具体来说,通过与人类操作员进行互动,操作员对模型生成的回答进行评价和反馈,给出奖励信号或惩罚信号,以引导模型生成更好的回答。

为了训练强化学习模型,需要定义一个奖励函数或者评价指标。例如,可以使用BLEU分数来衡量模型生成的回答与人工标注回答之间的相似度。操作员根据模型生成的回答的BLEU分数给出相应的奖励或惩罚,模型通过与操作员的交互逐渐优化回答的质量。

在强化学习阶段,模型从之前的对话和用户输入中提取关键信息,并根据当前的对话上下文生成回答。模型不断通过与操作员的互动,学习到生成更准确、合理的对话回答。

综上所述,ChatGPT通过预训练、微调和强化学习三个阶段的训练,使模型具备了生成具有上下文感知能力的自然语言回答的能力。

参考链接:聊天GPT模型训练成本分析及优化建议(chatgpt 训练成本)

预训练阶段

ChatGPT的模型训练过程分为预训练阶段、监督微调阶段和指令微调阶段。在预训练阶段,模型利用海量的对话数据进行无监督学习,以获得语言学知识和对自然语言的理解能力。

数据准备

为了进行预训练,需要采集相关的对话数据。这些对话数据可以来自各种渠道,如社交媒体、聊天记录等。采集到的数据需要进行预处理和清洗,以去除噪声和不完整的对话。

模型设计

ChatGPT使用深度学习模型,并借助掩码语言模型进行训练。深度学习模型的设计是关键,要能够准确地理解和生成对话内容。

- 掩码语言模型进行训练:ChatGPT利用掩码语言模型对对话进行预训练。通过掩码语言模型的训练,模型可以学习到对话中的上下文关联性和语言知识。

模型训练

在预训练阶段结束后,模型需要进行监督微调和指令微调,以获取特定任务的模型。

- 自监督学习的训练方式:ChatGPT的训练过程采用了自监督学习的方式。自监督学习是一种无监督学习的延伸,通过利用数据中的自动生成标签来进行训练。

- 反向传播和梯度下降的应用:模型训练过程中使用反向传播和梯度下降的方法来更新模型参数,以使模型的输出逼近于真实标签。

在预训练阶段和微调阶段,ChatGPT通过学习大量文本数据和特定任务的训练数据,获得了对自然语言的理解和生成能力。这种训练方式使得ChatGPT能够生成自然流畅的对话内容,并在不同场景下应用于实际任务。

参考链接

如果你对ChatGPT生成Midjourney绘画指令的训练方法感兴趣,可以参考ChatGPT生成Midjourney绘画指令的训练方法(如何训练chatgpt用于生成midjourney绘画指令)。

ChatGPT的训练过程

ChatGPT是一种基于GPT模型的对话生成模型,它能够根据输入的对话历史和上下文生成自然流畅的回复。ChatGPT的训练过程分为预训练和微调两个阶段。

预训练阶段

在预训练阶段,ChatGPT通过学习海量的文本数据来获取语言学知识。预训练使用无监督学习的方式进行,即模型在没有标注数据的情况下自我学习。ChatGPT使用Transformer结构进行预训练,通过对输入文本的各个位置进行建模,从而对语言的上下文关系进行理解。

在预训练过程中,ChatGPT模型会预测每个位置的下一个词是什么,这样它就可以学习到句子中词与词之间的关系和句法结构。通过长时间的预训练,ChatGPT可以获得对自然语言的理解和表达能力,成为一个强大的语言模型。

预训练的目标是让模型尽可能地捕捉文本数据的统计规律和语义特征,以便能够在下游任务中提供有用的信息。

微调阶段

在预训练阶段之后,ChatGPT需要通过微调来适应特定的任务。微调阶段的目标是使用特定任务的训练数据来获得对话生成模型的特定目标。

微调阶段分为三个步骤:

1. 监督微调

首先进行监督微调,这一步骤与预训练阶段类似,但使用的是具有监督标签的对话数据进行训练。通过与此阶段相同的监督学习模型对ChatGPT进行微调,将特定任务的标签信息引入模型。

这可以让ChatGPT在指定任务中具有更好的表现,生成更准确、自然流畅的回答。监督微调的目标是提高模型在下游任务上的准确性和性能。

2. 奖励建模

接下来进行奖励建模的训练。奖励建模的目标是训练一个回报模型,该模型可以根据对话的质量对ChatGPT进行评估和奖励。

在这个阶段,使用第一阶段生成的问题作为输入,通过训练回报模型来衡量生成的回答质量。这样,ChatGPT就可以在生成回答时更加准确地衡量质量和一致性。

3. 强化学习

最后,使用基于PPO算法的强化学习对ChatGPT进行训练。强化学习的目标是优化模型的生成回答质量,并提高与用户的交互效果。

通过基于PPO算法的强化学习训练,ChatGPT可以根据用户的反馈进行调整,以生成更加准确、有逻辑的回答。这样,ChatGPT就可以更好地满足用户的需求,提供更好的对话体验。

参考链接:ChatGPT训练过程图示例及解析

评估与优化

在ChatGPT的训练过程中,评估模型的性能,并进行优化,是非常重要的。评估模型的质量和准确性可以帮助我们了解模型的表现,并且根据评估结果进行优化,以提高模型的性能。

模型评估

为了评估ChatGPT的性能,我们需要使用测试数据集对模型进行评估。测试数据集是与训练数据集不同的未见过的数据,用于模拟实际应用场景。通过评估模型在测试数据集上生成回答的质量和准确性,可以判断模型是否达到预期的效果。

超参数调优

超参数是在训练过程中需要调整的参数,它们不是通过训练学习得到的,而是需要人工选择和调整的。选择合适的超参数可以对模型的性能产生重要影响。

- 学习率:学习率是控制模型在训练过程中参数更新的速度。如果学习率过小,模型收敛速度会慢;如果学习率过大,模型可能无法收敛。调整学习率可以达到更好的性能。

- 批次大小:批次大小是训练中每次输入到模型中的样本数量。较小的批次大小可以提高模型的泛化能力,但也会增加训练时间;较大的批次大小可以提高训练速度,但也可能导致模型过拟合。

- 训练轮数:训练轮数是指将整个训练数据集训练多少次。增加训练轮数可以提高模型的性能,但也可能导致模型过拟合,因此需要在效率和性能之间进行权衡。

通过调整这些超参数,我们可以对ChatGPT进行微调,以获得更好的性能。

chatgpt训练流程的常见问答Q&A

Q: ChatGPT的训练过程包括哪些步骤?

A: ChatGPT的训练过程主要分为三个阶段:预训练、微调、指令微调。下面是详细的训练步骤:

- 预训练(Pretraining):在预训练阶段,ChatGPT使用大规模的未标记文本数据进行无监督学习。模型通过使用Transformer结构,在海量的语料库上学习语言知识和上下文关联性。

- 微调(Fine-tuning):在微调阶段,ChatGPT使用特定任务的训练数据对预训练模型进行有监督的微调。这样可以使模型更加适应特定任务,并提高模型的性能和准确性。

- 指令微调(Instruction Fine-tuning):指令微调是ChatGPT特有的一项训练步骤。在这个阶段,ChatGPT通过使用人类反馈来指导模型的生成行为,以进一步提高模型的表现。

在这些训练步骤中,ChatGPT通过不断调整模型参数和优化训练算法,逐渐提高模型的生成能力和语言理解能力。

Q: ChatGPT的预训练阶段是如何进行的?

A: ChatGPT的预训练阶段采用了海量的未标记文本数据进行无监督学习。具体步骤如下:

- 数据准备:收集与训练任务相关的大规模文本数据,并进行预处理和清洗,以提高数据的质量。

- 模型设计:使用Transformer架构来构建预训练模型,该模型能够有效地处理语言信息,并具有强大的表达能力。

- 模型训练:将准备好的数据输入到预训练模型中进行训练。训练过程中,模型使用掩码语言模型(Masked Language Model,MLM)方法,通过给定上下文信息预测被掩盖的词汇。

通过预训练阶段,ChatGPT能够学习到丰富的语言知识和上下文关联性,为后续的微调和指令微调阶段奠定了基础。

Q: ChatGPT的微调阶段是如何进行的?

A: ChatGPT的微调阶段是在预训练阶段之后进行的,主要目的是对预训练模型进行进一步优化和调整,使其更适应特定任务和场景。微调阶段的主要步骤如下:

- 数据准备:收集与目标任务相关的训练数据,并根据任务需求进行数据预处理和清洗,提高数据的质量。

- 模型加载:将预训练模型的参数加载到微调模型中,作为初始参数。

- 模型训练:将准备好的训练数据输入到微调模型中进行训练。训练过程中,模型根据任务目标函数进行优化,调整模型参数,以提高模型性能和准确性。

通过微调阶段,ChatGPT能够对不同任务进行个性化定制和优化,使其在特定场景下更具有表现力和适应性。

Q: ChatGPT的指令微调阶段是什么意思?

A: ChatGPT的指令微调阶段是在微调阶段之后进行的一项训练步骤。在这个阶段中,ChatGPT通过使用人类反馈来指导模型的生成行为,以进一步提高模型的性能和准确性。指令微调的具体步骤如下:

- 收集人类反馈:收集人类对模型生成内容的评价和反馈,包括对生成回答的修改、修订和评分。

- 训练奖励模型:使用收集到的人类反馈数据,训练一个奖励模型。奖励模型通过对生成内容进行评分,给出每个回答的质量分数。

- 更新预训练模型:利用奖励模型的分数来指导预训练模型参数的更新,使模型能够生成更符合人类预期的回答。

通过指令微调阶段,ChatGPT可以进一步提高模型对人类意图的理解和表达能力,生成更准确和符合预期的回答。

Q: ChatGPT的训练过程在语言模型方面有哪些创新之处?

A: ChatGPT的训练过程在语言模型方面有几个创新之处:

- 无监督预训练:ChatGPT通过海量未标记文本数据进行无监督预训练,弥补了传统监督学习的不足之处,使模型能够自主学习语言知识和上下文关联性。

- 微调和指令微调:通过微调和指令微调两个阶段的训练,ChatGPT能够根据特定任务和人类反馈进行模型参数的优化和更新,提高模型性能和准确性。

- 掩码语言模型(Masked Language Model,MLM):在训练过程中,ChatGPT使用掩码语言模型的方法,通过上下文信息预测被掩盖的词汇,使模型具备了对语言知识的理解和推理能力。

这些创新使ChatGPT成为一种强大的语言模型,能够实现自然流畅的生成对话和与人类的交互。

结束