加我微信:laozhangdaichong7。确保你能用上 ChatGPT 官方产品和解决 Plus 升级的难题。本站相关服务↓

- ChatGPT一直转圈,专用网络美国海外专线光纤:老张渠道八折优惠。立即试用>

- GPT3.5普通账号:美国 IP,手工注册,独享,新手入门必备,立即购买>

- GPT-4 Plus 代充升级:正规充值,包售后联系微信:laozhangdaichong7。下单后交付>

- OpenAI API Key 独享需求:小额度 GPT-4 API 有售,3.5 不限速。立即购买>

- OpenAI API Key 免费试用:搜索微信公众号:紫霞街老张,输入关键词『试用KEY』

下单后立即获得账号,自助下单 24小时发货。很稳定,哪怕被封免费换新,无忧售后。

立即购买 ChatGPT 成品号/OpenAI API Key>>

请点击,自助下单,即时自动发卡↑↑↑

ChatGPT对GPT-3训练方法详解

ChatGPT是OpenAI基于GPT-3模型开发的一种聊天式AI模型,它在自然语言处理领域具有广泛的应用。为了使ChatGPT能够具备更加智能和准确的聊天能力,OpenAI采用了一种结合监督学习和强化学习的训练方法进行模型的迭代和优化。

了解ChatGPT与GPT-3的关系

首先,ChatGPT是基于GPT-3模型进行开发的。GPT-3(Generative Pre-trained Transformer 3)是一种基于Transformer架构的自然语言处理模型,拥有1750亿个参数,是目前最大的预训练语言模型之一。ChatGPT是基于GPT-3的一种改进版本,专注于生成自然、连贯的对话。

ChatGPT与GPT-3的联系在于它们共享了相同的基础结构和模型架构,但ChatGPT经过了特定的微调和训练,使其能够更好地适应于对话生成的任务。

了解ChatGPT与GPT-3的区别

尽管ChatGPT与GPT-3在模型结构上相似,但它们在训练和应用领域上存在一些差异。ChatGPT经过了特定的训练和微调,旨在更好地适应对话生成任务。与此相对,GPT-3是一个通用的预训练语言模型,可以用于各种自然语言处理任务。

ChatGPT的训练方法相对于GPT-3来说更加复杂,它通过多个阶段的训练来提高对话生成的质量。下面将详细介绍ChatGPT的训练方法。

ChatGPT对GPT-3的训练方法

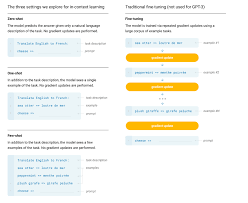

ChatGPT的训练方法可以分为三个主要的阶段:监督学习方式的微调、奖赏模型训练和基于PPO算法的强化学习训练。

第一阶段:监督学习方式的微调

在这个阶段,ChatGPT使用了与人工助手进行的对话数据进行训练。这些对话数据是根据人类演示者与人工助手之间的互动生成的。ChatGPT根据与人工助手的对话数据进行微调,以提高对话生成的质量和连贯性。

通过监督学习方式的微调,ChatGPT能够学习到人类对话的模式和规则,并能够生成更加符合语法和逻辑的回复。

第二阶段:奖赏模型训练

在第二阶段,ChatGPT使用了强化学习中的奖赏模型进行训练。在这个阶段,OpenAI创建了一个称为ChatGPT Playground的平台,邀请用户提供反馈和评分来衡量ChatGPT生成回复的质量。

根据用户的反馈和评分,OpenAI采用了基于奖赏模型的训练方法,通过增加那些获得较高评分的回复的概率,来进一步优化ChatGPT的生成能力。

第三阶段:基于PPO算法的强化学习训练

在第三阶段,OpenAI采用了一种基于Proximal Policy Optimization(PPO)算法的强化学习训练方法,进一步提升ChatGPT的表现。

PPO算法是一种适用于连续动作和状态的强化学习算法,它通过反复迭代训练和更新ChatGPT的策略,以使其能够生成更加合理和富有逻辑的回复。

ChatGPT对GPT-3训练方法详解

ChatGPT是基于GPT-3模型开发的对话生成模型,可以视为GPT-3的一种应用。它与GPT-3共享相同的基础架构和参数设置,但经过了进一步的训练和微调以提供更好的对话生成能力。

ChatGPT与GPT-3的联系

ChatGPT与GPT-3有着紧密的联系。可以将ChatGPT视为GPT-3在对话生成任务上的一种应用。它利用了GPT-3的强大语言生成能力,并通过训练和微调使其更加适用于生成自然对话。

ChatGPT与GPT-3的区别

尽管ChatGPT与GPT-3共享相同的基础架构和参数设置,但ChatGPT相对于GPT-3在对话生成任务上有一些特定的改进。

- ChatGPT的设计目标是使其更适合生成自然对话,因此在训练方法上与GPT-3有所不同。

- ChatGPT经过了监督学习的微调,使用人工标注的对话数据进行训练,以提升对话生成的能力。

- ChatGPT还利用强化学习方法,在与人类用户的互动中得到反馈并通过多轮对话进行训练,以提高生成质量。

- 最后,ChatGPT采用了基于PPO算法的强化学习训练,通过与模型之间的对话训练以及与多个模型之间的对话进行自我对抗,来进一步提高生成多样性和对话质量的表现。

ChatGPT的训练方法

ChatGPT的训练方法包括三个阶段:

- 第一阶段:监督学习方式的微调

- 第二阶段:奖赏模型训练

- 第三阶段:基于PPO算法的强化学习训练

ChatGPT的第一阶段训练采用了监督学习的方式。在这个阶段,使用人工标注的数据,将ChatGPT与人类生成的对话进行训练,以便模型能够学习到更好的对话生成能力。

第二阶段是ChatGPT的奖赏模型训练阶段。在这个阶段,ChatGPT使用强化学习的方法,在与人类用户的互动中得到反馈,通过多轮对话的训练来提升生成质量。

ChatGPT的第三阶段训练采用了基于PPO算法的强化学习方法。通过与模型之间的对话进行训练,以及与多个模型之间的对话进行自我对抗,来提高生成多样性和对话质量的表现。

总的来说,ChatGPT通过不同阶段的训练和微调,利用监督学习和强化学习方法提升了对话生成的能力,使其更适用于生成自然对话。

参考链接:ChatGPT的训练数据集是如何构建的?

chatgpt对gpt 3的训练方法的常见问答Q&A

Q: GPT-3是如何训练得到的?

A: 为了训练GPT-3,OpenAI使用了一种自回归语言模型的方法。具体来说,他们训练了一个拥有1750亿参数的模型。下面是GPT-3的训练过程:

- 第一阶段:监督学习。在这一阶段,模型通过对人工标注数据进行训练,学习如何根据输入生成对应的输出。这些人工标注数据被认为是高质量和准确的。

- 第二阶段:奖赏模型。在这一阶段,模型通过与人类进行对话来进行训练。模型会尝试生成不同的回答,并根据人类的反馈来调整自己的输出,以获得更好的结果。

- 第三阶段:强化学习模型。在这一阶段,模型通过使用PPO算法来训练。PPO算法是一种强化学习算法,可以帮助模型在与人类对话的过程中学习到更好的对话策略。

Q: GPT-3在训练过程中使用了什么数据?

A: 在训练GPT-3时,OpenAI使用了大量的NLP数据集。这些数据集包含了各种不同类型的文本数据,例如新闻文章、网页内容、书籍等。通过使用这些数据集,GPT-3可以学习到丰富的语义和语法知识。

Q: 什么是ChatGPT的训练框架?

A: ChatGPT的训练框架包括了人工标注数据和强化学习。具体来说,训练过程分为以下三个阶段:

- 第一阶段:使用GPT-3模型本身进行训练。虽然GPT-3非常强大,但是它很难理解不同类型的人类指令中所包含的不同含义。在这个阶段,模型通过自我训练来改善理解能力。

- 第二阶段:训练奖赏模型。在这个阶段,模型通过与人类进行对话,并根据人类的反馈来优化自己的回答。模型会尝试不同的回答,并根据人类的评价来调整策略。

- 第三阶段:基于PPO算法的强化学习模型训练。在这个阶段,模型通过使用PPO算法来学习更好的对话策略。PPO算法可以帮助模型在与人类对话的过程中逐步改进自己的回答。