加我微信:laozhangdaichong7。确保你能用上 ChatGPT 官方产品和解决 Plus 升级的难题。本站相关服务↓

- ChatGPT一直转圈,专用网络美国海外专线光纤:老张渠道八折优惠。立即试用>

- GPT3.5普通账号:美国 IP,手工注册,独享,新手入门必备,立即购买>

- GPT-4 Plus 代充升级:正规充值,包售后联系微信:laozhangdaichong7。下单后交付>

- OpenAI API Key 独享需求:小额度 GPT-4 API 有售,3.5 不限速。立即购买>

- OpenAI API Key 免费试用:搜索微信公众号:紫霞街老张,输入关键词『试用KEY』

下单后立即获得账号,自助下单 24小时发货。很稳定,哪怕被封免费换新,无忧售后。

立即购买 ChatGPT 成品号/OpenAI API Key>>

请点击,自助下单,即时自动发卡↑↑↑

ChatGPT的训练数据规模到底有多大?

ChatGPT训练数据的来源和组成与其性能密切相关。由于OpenAI未公开ChatGPT的具体训练数据集,但根据公开的信息和推测,我们可以对其进行一些估计。

ChatGPT最大版本的训练数据量达到了1750亿参数,具体来说,这需要大量的CPU/GPU进行24小时不间断地输入数据。据估计,这相当于开车往返于地球和月球,一次运算就要花费450万美元。

ChatGPT的训练数据主要来自于海量的互联网文本数据。具体用于训练ChatGPT的数据集及其构成是OpenAI团队所持有的商业机密,未对外公开。虽然没有公开的具体数据量,但ChatGPT的训练数据来源包括维基百科、书籍、期刊、Reddit链接、Common Crawl等多个数据集。

数据集的规模固然重要,但数据集的质量对于模型的性能同样至关重要。数据集的质量可以影响ChatGPT在推理、语法和逻辑上的准确性。因此,OpenAI在选择数据集时会非常慎重,以确保训练数据的准确性和多样性。

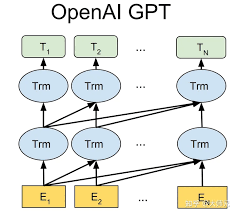

ChatGPT的训练数据集虽然庞大,但不是模型性能的唯一因素。训练算法的选择、模型架构的设计以及超参数的调整也都对模型性能起着重要的影响。因此,将训练数据和其他因素综合考虑,才能得到ChatGPT强大的模型性能。

ChatGPT的训练数据量对模型效果的影响

- 训练数据量的大小直接影响到模型的语言理解和生成能力。较大的数据量让模型具备更准确和多样化的回答能力。

- 更大的训练数据可以提高模型的泛化能力,让其在面对不同领域和主题的问题时表现更好。

- 大规模的训练数据可以帮助模型更好地处理复杂和具有歧义的问题,并减少误解或错误的回答。

- 适当的训练数据量可以提高模型的鲁棒性,使其在面对噪声和干扰时仍能保持良好的性能。

ChatGPT最大版本的训练数据量

ChatGPT最大版本的训练数据量达到了1750亿参数。这一庞大的数据量需要大量的计算资源和时间来输入和处理。

ChatGPT训练数据的来源和组成

具体用于训练ChatGPT的数据集及其构成是OpenAI团队的商业机密,未对外公开。根据公开的信息和推测,ChatGPT的训练数据主要来源于维基百科、书籍、期刊、Reddit链接、Common Crawl等多个数据集。

这些数据集包含了海量的互联网文本数据,涵盖了各个领域和主题的知识和信息。

ChatGPT训练数据对模型性能的影响

ChatGPT的训练数据量和质量对模型性能起着重要的影响,但并不是唯一的因素。训练算法、模型架构和超参数等也都对模型的性能产生重要影响。

在选择训练数据时,OpenAI会综合考虑训练数据的规模、质量和多样性,以及其他因素,来提高ChatGPT的性能和表现。

ChatGPT的训练数据量对模型效果的影响

增加训练数据量对模型效果的直接增长

从现有研究结论来看,增加训练数据量可以直接提高ChatGPT模型的效果。当模型规模固定时,持续增加训练数据量可以进一步增强模型的性能。例如,OpenAI发布的Mistral 7B模型使用了8个T的训练数据,使得其基础模型效果非常强大。

ChatGPT的模型规模与训练数据量的关系

模型规模越大,训练数据量的要求也越大。ChatGPT最大版本GPT-3使用了45TB的训练数据,其中包括数十亿的单词和数万亿的字符,覆盖了各个领域的数据集。这样的大规模训练数据为模型的性能提供了强有力的支持。

更多的训练数据可以使模型具有更好的泛化能力和稳定性,减少过拟合程度。ChatGPT需要较大的训练数据量才能训练出更好的模型性能。例如,使用更大的训练数据集可以提高ChatGPT在聊天机器人生成任务中的生成效果。

因为训练得到的模型是对训练集分布的一个拟合,训练数据集的分布是影响生成模型内容质量的一个重要因素。增加训练数据量可以更好地捕捉语言的规律和结构,从而提高生成模型的质量。

ChatGPT训练数据量的重要性

训练数据量的增加对于ChatGPT模型的性能和生成效果具有重要的影响。通常情况下,训练数据量越大,模型的性能和生成效果越好。

在ChatGPT模型训练中,数据量的增加可以提高模型的泛化能力和稳定性,减少过拟合程度。更多的训练数据可以使模型建立更准确的语言模型,提高生成文本的流畅度和准确性。

经典的fine-tuning方法是将预训练模型与少量任务特定数据一起训练,而fine-tuning的量取决于预训练语料库和任务特定语料库之间的相似性。ChatGPT模型在许多任务上进行了微调,包括文本摘要、翻译和对话生成等,这些微调过程也需要大量的训练数据来取得良好的效果。

总结而言,增加ChatGPT的训练数据量可以直接提高模型的效果。更大的训练数据量可以提高模型的泛化能力和稳定性,减少模型的过拟合程度,从而提高生成文本的质量和准确性。

ChatGPT最大版本的训练数据量

目前ChatGPT最大的版本为GPT-3,训练使用的数据量达到了45TB。ChatGPT的数据规模是指训练模型所使用的数据量以及参数规模。ChatGPT-4的数据集据估计包括100万亿个参数,是历代版本的5倍以上。

包含的数据类型和来源

ChatGPT的训练数据集包括了数十亿的单词和数万亿的字符,涵盖了各种领域的数据集。主要来源包括英文和中文维基百科、新闻、书籍、网页和其他公开可用的文本数据集。这些数据集包括原始网页、元数据和提取的文本,并以每月20TB 的速度持续新增。

ChatGPT 不仅要求大量的训练数据,还要求高质量的训练数据。ChatGPT的训练数据集经过精心的挑选和预处理,以确保模型能够学习到各种复杂的语言结构和语义关系。

训练过程中的算力需求

由于训练数据量庞大,ChatGPT对计算资源的需求非常高。GPT-3.5 的训练使用了由1万个V100 GPU组成的高性能网络集群,总算力之大令人惊叹。这样的算力可以提供足够的计算资源来进行大规模的模型训练。

值得一提的是,训练数据量和模型规模的增加会带来更高的训练时间和成本。ChatGPT-4相比于ChatGPT-3.5来说,训练数据量和模型架构更大,因此它的训练时间和成本也会更高。

训练数据主要来源与隐私保护措施

ChatGPT的训练数据主要来源于公开可用的文本数据集,包括维基百科、新闻、书籍和网页等。OpenAI并没有公开训练ChatGPT的具体数据集来源和细节,这是为了保护数据提供者的隐私和保密商业信息。

OpenAI对训练数据的使用也非常重视隐私保护。他们采取了一系列的技术和措施来确保训练数据的隐私。例如,他们会对训练数据进行匿名化处理,以防止数据中可能存在的个人身份信息被泄露。

另外,OpenAI也非常注重模型的性别、种族和政治中立性。他们致力于开发和维护一个平衡和包容的AI系统,以避免偏见和歧视的问题。

总的来说,ChatGPT的训练数据量和数据来源都经过仔细的筛选和保护,以保证模型的高质量和隐私保护。

ChatGPT训练数据的来源和组成

ChatGPT的训练数据是非常重要的,它决定了模型的质量和表现。下面我们来分析ChatGPT训练数据的来源和组成。

主要数据来源

ChatGPT的训练数据主要来源于英文和中文维基百科,还包括大量的新闻、书籍、网页和其他公开可用的文本数据集。这些数据集包含了海量的互联网文本数据,其中包括了语言的各种形式和用法。

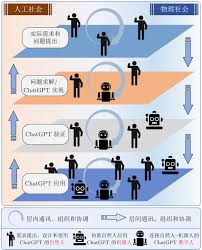

在数据收集阶段,OpenAI从各种来源收集原始数据,并对数据进行清洗和预处理,以提高训练效果。他们使用了一种称为无监督学习的方法,这意味着他们并没有对模型进行人工标注,而是依靠大规模的无监督文本数据来进行训练。

数据集的构成

具体的数据集构成尚未公开,因此我们不清楚具体的数据集大小、数据集中的token数量以及数据集的内容细节。但是可以确定的是,ChatGPT的训练数据包含了各种类型的无监督文本数据,如网页、书籍、新闻文章等。

这些数据集不仅包括了通用领域的文本,还包括了特定领域的文本。通过使用具有广泛覆盖领域的数据集,ChatGPT可以在面对各种问题时提供更准确的回答。

总之,ChatGPT的训练数据是从互联网的海量无监督文本数据中提取的,数据来源包括维基百科、新闻、书籍、网页等。这些数据经过清洗和预处理,用于训练模型。虽然具体的数据集构成尚未公开,但可以确定的是数据集涵盖了各种语言形式和用法,可以提供良好的语言理解和生成能力。

ChatGPT训练数据对模型性能的影响

ChatGPT是一款基于大规模语言模型的对话生成系统,其训练数据量对于模型性能的影响至关重要。本文将探讨训练数据量对ChatGPT模型性能的影响以及训练数据量的增加对模型性能的提升。

训练数据量对模型性能的影响

一般来说,ChatGPT需要的数据量越大,训练出的模型性能也越好。当前最大规模的GPT-3模型的训练数据量高达45TB,模型参数量高达1.75万亿,可以实现更好的生成效果。

训练数据量增加对模型性能的提升

根据大语言模型过去4年的发展趋势分析,每过1年就需要双倍的数据量来训练模型,以实现性能和功能的提升。随着数据规模的增加,模型可以从更多的上下文中学习到更准确的语言模式和知识,从而提升生成文本的质量。

然而,增加训练数据量也带来了一些挑战。在现实世界中,文本数据往往包含噪音和错误,这可能会对模型的性能产生负面影响。因此,数据的质量和准确性也需要被重视,包括对数据进行清洗和筛选,以确保数据的可靠性。

除了数据量的增加,模型的参数量也是影响模型性能的因素之一。更大规模的模型可以拥有更多的参数来存储和表示语言模式和知识,从而提高生成文本的准确性和多样性。

总结而言,训练数据量对ChatGPT模型的性能有着重要的影响,大规模的数据集和模型参数量可以提升模型的表现。然而,数据质量和准确性也需要被重视,以确保训练出的模型能够生成高质量、准确的对话内容。

chatgpt训练数据量的常见问答Q&A

问题:ChatGPT的训练数据集是如何构建的?

答案:ChatGPT的训练数据集是通过收集大量的互联网文本数据进行构建的。具体而言,OpenAI团队收集了来自各种来源的文本数据,包括英文和中文维基百科、新闻、书籍、网页等。这些数据集包含了海量的无监督文本数据,涵盖了各种领域的知识和信息。

为了构建ChatGPT的训练数据集,OpenAI还使用了一种称为无监督学习的方法。这意味着他们并没有对数据集进行特定任务的标注,而是利用其丰富的语言模型能力从原始文本中自动学习语言规则和知识。

总结起来,ChatGPT的训练数据集是通过收集各种来源的互联网文本数据,并利用无监督学习方法进行构建的。

问题:ChatGPT的训练数据量有多大?

答案:ChatGPT的训练数据量是一个商业机密,OpenAI并没有公开具体的数据量大小。然而,根据相关资讯和研究预估,GPT-3模型的训练数据量高达45TB。这个数据集包含了数十亿的单词和数万亿的字符,并覆盖了各种领域的文本数据。

训练数据量的增加对于模型性能的提升是有积极影响的。一般来说,训练数据量越大,模型的泛化能力和稳定性越好,可以更好地捕捉语言的规律和特征。

总结一下,尽管ChatGPT的具体训练数据量未公开,但根据预估,其数据量可能达到了数十TB,这对于训练一个高性能的语言模型至关重要。

问题:ChatGPT的模型参数量有多大?

答案:ChatGPT模型的参数量也是一个商业机密,OpenAI并没有公开具体的参数量大小。然而,根据研究推测,最大规模的GPT-3模型有1750亿个参数。这些参数用于表示模型的权重和偏置,决定了模型的能力和表达能力。

值得注意的是,训练数据量和模型参数量是相互关联的。一般来说,训练数据量和参数量越大,模型的性能和效果也会更好。大量的训练数据可以帮助模型更好地学习语言的规律和特征,而更多的参数可以提供更强大的表达能力。

综上所述,ChatGPT的模型参数量可能达到了数百亿甚至千亿级别,这对于构建一个强大而高性能的语言模型至关重要。

问题:ChatGPT的训练数据对模型性能有何影响?

答案:ChatGPT的训练数据对模型的性能有重要影响。一般来说,训练数据量越大,模型的性能和效果越好。

较大的训练数据集可以提供更多的语言样本和语境,使得模型能够更好地学习语言的规律和特征。通过观察和分析更多的文本数据,模型可以学到更准确和全面的知识,从而在对话中表现出更强的理解和生成能力。

此外,多样化和代表性的训练数据也有助于提高模型的泛化能力。通过包含不同领域、不同类型的文本数据,模型可以更好地适应各种不同的应用场景和需求,从而具备更广泛的应用价值。

综上所述,训练数据对ChatGPT的性能具有重要影响,较大、多样化和代表性的数据集可以帮助模型达到更好的学习效果和生成质量。

问题:ChatGPT的训练数据集中包括哪些来源的文本数据?

答案:ChatGPT的训练数据集来源多样,主要包括英文和中文维基百科、新闻、书籍、网页等公开可用的文本数据集。

英文维基百科是ChatGPT训练数据集中的主要来源之一。维基百科是一个免费且包含大量知识的在线百科全书,它覆盖了众多领域的知识和信息。

此外,ChatGPT的训练数据集还包括海量的新闻文章、书籍文本和公开可用的网页数据。这些数据来源涵盖了不同领域的知识,使得模型在训练过程中可以学到更丰富和多样的语言规律和知识。

综上所述,ChatGPT的训练数据集主要包括英文和中文维基百科、新闻、书籍、网页等来源的文本数据。

问题:ChatGPT的训练数据来源是否包括中文文本?

答案:是的,ChatGPT的训练数据来源中包括了中文文本。除了英文维基百科、新闻、书籍和网页数据之外,OpenAI还收集了大量公开可用的中文文本数据,用于构建ChatGPT的训练数据集。

中文作为世界上最重要的语言之一,拥有丰富的文化和知识资源。通过引入中文训练数据,ChatGPT可以更好地理解和生成中文语言,满足中文用户的需求。

综上所述,ChatGPT的训练数据来源包括中文文本,使得模型在中文语境下的应用具有更好的性能。

问题:为什么ChatGPT的训练数据量和参数量都很大?

答案:ChatGPT的训练数据量和参数量之所以很大,是为了提高模型的性能和效果。

较大的训练数据量可以提供更多的语言样本和语境,使得模型可以更好地学习语言的规律和特征。通过观察和分析更多的文本数据,模型可以学到更准确和全面的知识,从而在对话中展现出更强的理解和生成能力。

同时,较多的模型参数可以提供更强大的表达能力,使得模型可以更好地学习和表示语言的复杂结构和语义关系。更多的参数意味着模型可以更详细和准确地表示文本信息,从而提高生成的质量和多样性。

综上所述,ChatGPT的训练数据量和参数量之所以很大,是为了确保模型具备更好的学习能力、表达能力和生成能力。

问题:ChatGPT的训练数据与使用场景有什么关联?

答案:ChatGPT的训练数据与使用场景之间有密切的关联。训练数据的多样性和代表性可以决定模型在不同应用场景下的表现。

ChatGPT的训练数据集包含了各种来源和领域的文本数据,涵盖了广泛的知识和信息。这使得ChatGPT可以适应不同的应用场景,如聊天机器人、自然语言对话、文本生成等。

通过在训练数据中包含具体的场景和领域的文本,模型可以更好地理解和生成与该场景相关的语言,提供更准确、自然和可靠的输出结果。

因此,训练数据的多样性和代表性对于模型的使用场景至关重要,可以决定模型在特定场景下的适应能力和性能。

问题:ChatGPT的训练数据规模如何影响模型的表现?

答案:训练数据规模对ChatGPT的模型表现有重要影响。一般来说,训练数据规模越大,模型的表现可能越好。

较大的训练数据规模可以提供更多的语言样本和语境,使得模型可以更全面地学习语言的规律和特征。通过观察和分析更多的文本数据,模型可以学到更准确和全面的知识,从而在对话中表现出更强的理解和语言生成能力。

此外,较大的训练数据规模还有助于提高模型的泛化能力。大规模训练数据可以覆盖更多的语言场景和语义信息,使得模型更好地适应不同的应用场景和需求。

综上所述,较大的训练数据规模对于提高ChatGPT模型的表现和性能具有积极的影响。

问题:ChatGPT的训练数据量与代码模型规模有何关联?

答案:ChatGPT的训练数据量与代码模型规模之间具有一定的关联。一般来说,较大的训练数据量可以支持更大规模的代码模型,并提升模型的性能和效果。

训练数据量的增加可以帮助模型更好地学习语言的规律和特征,提高其表达能力和学习能力。而较大规模的代码模型可以提供更多的参数和复杂度,使模型具备更大的表达能力和学习能力。

因此,当训练数据量较大时,可以支持更大规模的代码模型,从而获得更好的模型性能和效果。

问题:ChatGPT的训练数据量和模型参数是否成正比?

答案:是的,ChatGPT的训练数据量和模型参数之间通常存在正比关系。训练数据量越大,模型参数也需要越多。

训练数据量的增加可以提供更多的语言样本和语境,使得模型可以更好地学习语言的规律和特征。而模型参数的增加可以提供更强大的表达能力和学习能力,使得模型可以更好地表示和学习文本的复杂结构和语义关系。

因此,为了获得更好的模型性能和效果,一般来说,训练数据量和模型参数之间需要维持一定的正比关系。

问题:ChatGPT的训练数据和参数量为什么如此庞大?

答案:ChatGPT的训练数据和参数量之所以庞大,是为了提高其性能和效果。

较大的训练数据量可以提供更多的语言样本和语境,帮助模型更好地学习语言的规律和特征。大量的文本数据样本可以覆盖更广泛的语言场景和领域,使得模型具备更强的语言理解和生成能力。

模型参数量的增加则可以提供更强大的表达能力和学习能力,使得模型可以更准确地表示文本信息和学习文本特征。更多的参数意味着模型可以更详细和准确地表示语义关系和语法结构,从而提高生成的质量和多样性。

综上所述,庞大的训练数据和参数量是为了使ChatGPT具备更好的性能和效果,能够更好地理解和生成人类语言。