全面了解和快速实施GPT-SOVITS | ChatGPT | FastGPT | AutoGPT 本地部署教程,满足你的AI需求

说在前面

如今,人工智能(AI)技术在各个领域得到了广泛应用,尤其是自然语言处理(NLP)领域。然而,要充分利用这些AI模型,许多人发现了解其本地部署至关重要。本篇文章将全面介绍GPT-SOVITS、ChatGPT、FastGPT、AutoGPT以及DB-GPT的本地部署方法,并详解如何导入自己的数据和对显存的需求。我们期望通过本文,让你能够快速部署并灵活应用这些AI模型以满足各种需求。

[插图:关键词]

关键词背景介绍

定义和基本概念

GPT-SOVITS:GPT-SOVITS是一种基于Transformer架构的语音转换模型,能够将一个语音样本转换成另一个声音相似但内容不同的语音。

ChatGPT:ChatGPT是OpenAI开发的一种语言模型,通过深度学习算法生成类似人类对话的文本。

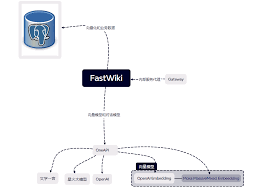

FastGPT:FastGPT是一种优化后的GPT模型,专门用于快速生成多轮对话。

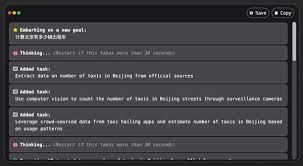

AutoGPT:AutoGPT是一种自动化的GPT模型,用于自主完成复杂任务,包括调研、内容生成等。

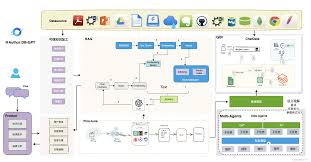

DB-GPT:DB-GPT是一种基于数据库操作的GPT模型,旨在通过自然语言处理进行数据查询和分析。

历史和发展

人工智能技术的发展源远流长,特别是神经网络和深度学习技术的突破极大推动了NLP的进步。自从2017年Transformer模型问世以来,各种GPT模型逐渐成为NLP领域的主流选择,从初期的GPT-2到如今的各类优化模型,这些技术正在改变我们与计算机互动的方式。

详细解读

GPT-SOVITS本地部署

要在本地部署GPT-SOVITS,首先需要准备适当的硬件资源(建议使用GPU)。具体步骤如下:

- 下载GPT-SOVITS源码并解压到本地目录。

- 安装所需的依赖库,包括TensorFlow和Transformer。

- 准备训练数据,在程序中指定语音转换的输入和输出样本。

- 启动训练脚本,开始模型的训练过程。

- 训练完成后,通过模型接口进行语音转换测试。

[插图:GPT-SOVITS]

ChatGPT本地部署

ChatGPT本地部署相对容易,具体步骤如下:

- 从GitHub下载ChatGPT的源码和预训练模型。

- 安装所需的开发环境,例如Python和PyTorch。

- 配置项目中的依赖库,可以使用`pip install -r requirements.txt`。

- 初始化模型并加载预训练权重。

- 运行测试脚本确保模型加载正确,并进行一些基本对话测试。

FastGPT本地部署

FastGPT是一种更快速的语言生成模型,适合实时对话。其本地部署步骤如下:

- 下载FastGPT的源码,并在本地解压。

- 安装必需的依赖项,包括加速库如CUDA和CuDNN。

- 配置环境变量,确保GPU可以被正确利用。

- 加载预训练模型,并进行参数微调以适应特定需求。

- 通过API接口测试模型的性能和响应速度。

AutoGPT本地部署

AutoGPT是一种高度自动化的GPT模型,适合复杂任务的自动化处理。部署步骤如下:

- 克隆AutoGPT代码库,并在本地解压。

- 安装所需的环境,包括Python 3.8+、pip、virtualenv等。

- 创建并激活虚拟环境:`virtualenv venv && source venv/bin/activate`。

- 安装所需依赖:`pip install -r requirements.txt`。

- 配置AutoGPT的任务参数,并启动任务管理模块。

DB-GPT本地部署

DB-GPT是一种通过自然语言进行数据库操作的模型。其本地部署步骤如下:

- 下载DB-GPT的源码和相关依赖。

- 安装数据库客户端和配置数据库连接参数。

- 初始化模型并加载相关训练数据。

- 运行数据库查询脚本并测试模型的查询效果。

相关Tips

以下是一些在本地部署过程中有用的建议:

- 尽量使用高性能GPU来加速模型训练和推理过程。

- 定期更新模型和依赖库,确保使用最新版本。

- 使用虚拟环境隔离项目,避免依赖冲突。

- 备份训练数据和模型权重,防止数据丢失。

- 利用日志记录和监控工具,跟踪训练和推理过程中的性能指标。

常见问题解答 (FAQ)

1. 本地部署这些模型需要多大显存?

显存需求因模型而异,通常需要8GB以上的显存,以确保顺利运行复杂的GPT模型。

2. 如何在本地部署时导入自己的数据?

可以通过配置训练脚本中的数据路径,将自己的数据集导入模型进行训练。

3. 为什么我的模型运行速度很慢?

可能是因为硬件性能不足,尤其是GPU。如果无法升级硬件,可以尝试优化模型和减少参数量。

4. 是否可以在本地环境中多模型共存?

是的,可以通过使用不同的虚拟环境和端口配置实现多模型共存。

5. 在本地部署和云端部署有什么区别?

本地部署不依赖外部服务,数据更安全,但需要更高的硬件要求。云端部署灵活性高,但可能存在隐私和安全问题。

总结

本文详细介绍了在本地部署GPT-SOVITS、ChatGPT、FastGPT、AutoGPT和DB-GPT等多种AI模型的方法。通过这些步骤,用户可以建立自己的AI系统并根据需求灵活应用这些技术。这些模型不仅可以增强工作效率,还能提供更精准的服务。在未来,随着更多高性能硬件的普及,本地部署AI将变得越来越普遍。

现在就开始动手吧,让这些强大的AI工具助你一臂之力!